Le point sur la régulation de l’IA en Europe

Il importe en effet de comprendre qu’en raison des utilités et des potentialités espérées de l'intelligence artificielle (IA), l’ensemble des pays choisissent de l'utiliser comme moyen de manifester leur volonté d'avancement technologique. L’encadrement réglementaire et régulatoire de l'IA n'en est donc qu'à ses débuts. Il s’agit ici de faire le point sur les différentes initiatives réglementaires concernant l’intelligence artificielle au niveau européen.

1. Une réflexion préalable de la Commission européenne : une communication, des lignes directrices et un livre blanc sur l’intelligence artificielle

Depuis 2018, l’Union européenne travaille sur une stratégie sur l'intelligence artificielle qui s’est dessinée progressivement.

L’Union européenne a débuté ses réflexions sur l'intelligence artificielle dans le cadre du marché unique numérique en publiant en avril 2018 une communication intitulée "L’intelligence artificielle pour l’Europe"[1]. Compte-tenu de l’importance stratégique de l’IA tant sur les plans juridiques, géopolitiques, commerciaux et sécuritaires, l’ambition de l’Union européenne consiste à devenir un acteur mondial de premier plan en matière d’innovation dans l’économie fondée sur les données et dans ses applications. C’est pourquoi la Commission européenne a aussi constitué en juin 2018 un groupe de haut niveau d’une cinquantaine d’experts indépendants pour définir les lignes directrices pour parvenir à une IA de confiance[2]. Celles-ci ont été publiées en avril 2019 et les membres de ce groupe ont notamment préconisé de :

- « Veiller à ce que la mise au point, le déploiement et l’utilisation de systèmes d’IA répondent aux exigences d’une IA digne de confiance : 1) action humaine et contrôle humain, 2) robustesse technique et sécurité, 3) respect de la vie privée et gouvernance des données, 4) transparence, 5) diversité, non-discrimination et équité, 6) bien-être sociétal et environnemental, et 7) responsabilité.

- Envisager des méthodes techniques et non techniques pour garantir la mise en œuvre de ces exigences.

- Encourager la recherche et l’innovation en vue de contribuer à l’évaluation des systèmes d’IA et de soutenir la mise en œuvre des exigences; diffuser les résultats et les questions ouvertes au grand public, et veiller à ce qu’une formation dans le domaine l’éthique en matière d’IA soit systématiquement dispensée à la nouvelle génération d’experts.

- Fournir de façon proactive des informations claires aux parties prenantes sur les capacités et les limites des systèmes d’IA, afin de leur permettre de formuler des attentes réalistes, ainsi que sur la manière dont les exigences sont mises en œuvre. Faire preuve de transparence sur le fait qu’elles interagissent avec un système d’IA.

- Faciliter la traçabilité et l’auditabilité des systèmes d’IA, en particulier dans les contextes ou situations critiques.

- Associer les parties prenantes tout au long du cycle de vie du système d’IA. Encourager la formation et l’éducation afin que toutes les parties prenantes soient renseignées sur l’IA digne de confiance et formées dans ce domaine.

- Savoir qu’il peut exister des tensions fondamentales entre différents principes et exigences. Recenser, évaluer, documenter et communiquer de manière continue ces arbitrages et leurs solutions »[3].

En février 2020, la Commission européenne a présenté ses orientations en matière d’intelligence artificielle par la parution d’un livre blanc "Intelligence artificielle - Une approche européenne axée sur l’excellence et la confiance"[4] qui a été soumis en consultation publique jusqu’en mai 2020.

La Commission européenne préconise, pour tout nouvel instrument juridique, une définition « suffisamment souple pour tenir compte des progrès techniques tout en étant suffisamment précise pour garantir la sécurité juridique nécessaire »[5]. La Commission rappelle que les règles en matière de protection des consommateurs et de protection des données à caractère personnel continueront de s'appliquer aux technologies d'intelligence artificielle, bien que ce cadre pourrait nécessiter certains aménagements pour tenir compte de la transformation numérique et du recours à l'IA. Comme résumé par Cécile Crichton, « certaines problématiques inhérentes à ces technologies génèrent de nouveaux risques, qui, selon la Commission, portent sur l’atteinte aux droits fondamentaux, d’une part, et sur la sécurité et le bon fonctionnement du régime de responsabilité, d’autre part (p. 12-15). Afin de s’en prémunir est prévue l’adaptation d’un certain nombre de règles (p. 15-16), mais aussi et surtout la création de nouvelles mesures (p. 21-26). Ces nouvelles mesures seront uniquement imputables aux applications d’intelligence artificielle “à haut risque” (p. 20-21), étant précisé que le haut risque est déterminé en fonction de deux critères cumulatifs : d’une part, en fonction du secteur (par ex. “les soins de santé, les transports, l’énergie et certains pans du secteur public”) et, d’autre part, en fonction de l’utilisation en elle-même. En effet, précise la Commission, un secteur à haut risque peut recevoir des applications ne portant pas de risque, à l’instar d’un “système de planification des rendez-vous dans un hôpital”»[6].

La Commission européenne précise que dans les domaines à haut risque, les systèmes d'IA devraient être transparents, traçables et garantir un contrôle humain. Par ailleurs, les autorités devraient être en mesure de tester et de certifier les données utilisées par les algorithmes. Des données sans biais sont nécessaires pour entraîner les systèmes à haut risque à fonctionner correctement et pour garantir le respect des droits fondamentaux. En ce qui concerne les applications d'IA à faible risque, la Commission européenne envisage un système de label non obligatoire si elles appliquent des normes plus élevées. Le livre blanc recommande que le marché européen soit accessible à l'ensemble des applications d'IA, pour autant que celles-ci soient conformes aux règles de l'UE. Ce livre blanc a servi de base pour la proposition de règlement sur la législation sur l’intelligence artificielle présentée par la Commission européenne en avril 2021.

2. Un encadrement général par la proposition de règlement sur la législation sur l’IA

La Commission européenne a fait le choix d’un cadre horizontal qui traite des problèmes communs à toutes les formes d’utilisation de l'intelligence artificielle. En effet, la Commission européenne a dévoilé en avril 2021 le premier cadre juridique sur l'IA au sein d’une proposition de règlement établissant des règles harmonisées concernant l’intelligence artificielle aussi dite légalisation sur l’intelligence artificielle et modifiant certains actes législatifs de l’Union européenne[7]. L’objectif de ce texte, sur lequel a porté une consultation publique ouverte jusqu’en août 2021, est d’asseoir une vision européenne de l’IA basée sur l’éthique en prévenant les risques inhérents à ces technologies par un règlement commun permettant d'encadrer les différents secteurs d'application de l'intelligence artificielle tout en évitant certaines dérives.

Il importe de souligner que le Comité et le Contrôleur européen de la protection des données ont publié un avis conjoint le 18 juin 2021 sur ledit texte[8]. Ils y saluent l'effort de protection et de définition de règles pour l'IA présentées dans la Proposition, mais émettent également des réserves et des craintes sur plusieurs de ses dispositions. En substance, l'avis conjoint appelle à des règles plus strictes et plus protectrices ainsi qu'à une meilleure prise en compte et articulation avec le règlement général sur la protection des données à caractère personnel.

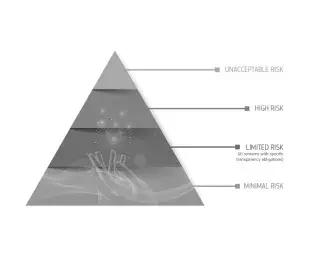

Une approche fondée sur les risques

La Commission européenne propose une approche fondée sur les risques, comportant quatre niveaux de risque :

- les risques considérés comme inacceptables qui regroupent un ensemble très limité d'utilisations de l'IA qui sont contraires aux valeurs de l'UE parce qu'elles portent atteinte à des droits fondamentaux et qui seront donc interdits. Figurent notamment parmi ce groupe la notation sociale par les gouvernements, l’exploitation de la vulnérabilité des enfants, le recours à des techniques subliminales et – sous réserve d'exceptions strictement limitées – l’utilisation par les forces de l'ordre de certains systèmes d'identification biométrique en temps réel et à distance dans les lieux accessibles au public.

- les risques identifiés comme élevés qui sont définis de manière limitative dans la proposition car ils ont une incidence négative sur la sécurité des personnes ou sur leurs droits fondamentaux tels que protégés par la Charte des droits fondamentaux de l'UE. Cette liste des systèmes d'IA à haut risque est annexée à la proposition. Elle est à l’épreuve du temps puisqu’elle pourra être révisée pour tenir compte de l'évolution des utilisations de l'IA.

- Ces systèmes comprennent notamment des composantes de sécurité de produits couverts par la législation sectorielle de l'Union. Ils seront toujours considérés comme à haut risque dès lors que, dans le cadre de cette législation sectorielle, ils sont soumis à une évaluation de la conformité par un tiers.

- Afin de promouvoir la confiance et de garantir un niveau élevé et uniforme de protection de la sécurité et des droits fondamentaux, des exigences obligatoires sont proposées pour tous les systèmes d'IA à haut risque. Ces exigences portent sur la qualité des ensembles de données utilisés, la documentation technique et la tenue de registres, la transparence et la fourniture d'informations aux utilisateurs, le contrôle humain, ainsi que la robustesse, l'exactitude et la cybersécurité. Grâce à ces exigences, les autorités nationales pourront, en cas d'infraction, disposer des informations nécessaires pour déterminer si le système d'IA a été utilisé dans le respect de la législation.

- Le cadre proposé est conforme à la Charte des droits fondamentaux de l'Union européenne et compatible avec les engagements commerciaux internationaux de l'UE.

- les risques présentés comme limités pour lesquels des obligations de transparence spécifiques sont imposées, par exemple lorsqu'existe un risque manifeste de manipulation (par exemple, du fait du recours à des chatbots). Les utilisateurs devraient savoir qu'ils interagissent avec une machine.

- enfin les risques dits minimaux c’est-à-dire tous les autres systèmes d'IA peuvent être développés et utilisés à condition de respecter la législation actuelle; ils ne sont soumis à aucune obligation légale supplémentaire. La grande majorité des systèmes d'IA actuellement utilisés dans l'UE appartiennent à cette catégorie. Les fournisseurs de ces systèmes peuvent volontairement choisir d'appliquer les exigences relatives à une IA digne de confiance, et adhérer à des codes de conduite volontaires.

La Commission européenne propose, outre une définition du « risque élevé », une méthode permettant de recenser les systèmes d'IA à haut risque pour l'application du cadre juridique. L'objectif est que les entreprises et les autres opérateurs jouissent d'une sécurité juridique. La classification des risques repose sur la finalité assignée au système d'IA, conformément à la législation existante de l'UE en matière de sécurité des produits. Cela signifie que cette classification dépend de la fonction exécutée par le système d'IA, ainsi que du but spécifique dans lequel le système est utilisé et des modalités de cette utilisation. Les critères de classification comprennent le degré d'utilisation de l'application d'IA et la finalité qui lui est assignée, le nombre de personnes sur lesquelles elle est susceptible d'avoir une incidence, la dépendance à l'égard des résultats et l'irréversibilité des dommages, ainsi que la mesure dans laquelle la législation actuelle de l'Union prévoit déjà des mesures efficaces pour prévenir ou réduire sensiblement ces risques.

Une liste recensant certains domaines critiques permet de clarifier le classement en indiquant quelles sont ces applications dans les domaines de l'identification et de la catégorisation biométriques, des infrastructures critiques, de l'éducation, du recrutement et de l'emploi, de la fourniture de services publics ou privés importants ainsi que dans ceux du maintien de l'ordre, de l'asile et de la migration et de la justice.

Une liste des cas d'utilisation que la Commission juge actuellement à haut risque est annexée à la proposition. La Commission fera en sorte que la liste des cas d'utilisation à haut risque soit pertinente et tenue à jour, en s'appuyant sur les critères et sur des éléments probants et des avis d'experts dans le cadre d'une consultation des parties prenantes. Avant qu'un fournisseur puisse mettre un système d'IA à haut risque sur le marché de l'UE ou le mettre en service d'une autre manière, ce système doit faire l'objet d'une évaluation de la conformité. Les fournisseurs pourront ainsi démontrer que leur système est conforme aux exigences obligatoires relatives à une IA digne de confiance (par exemple, la qualité des données, la documentation et la traçabilité, la transparence, le contrôle humain, l'exactitude et la robustesse). En cas de modification substantielle du système lui-même ou de sa finalité, l'évaluation devra être effectuée à nouveau. Pour certains systèmes d'IA, un organisme notifié indépendant devra également intervenir dans ce processus. Les systèmes d'IA constituant des composants de sécurité de produits couverts par une législation sectorielle de l'UE seront toujours considérés comme à haut risque dès lors qu'ils font l'objet d'une évaluation de la conformité réalisée par un tiers en vertu de cette législation sectorielle. Pour les systèmes d'identification biométrique également, une évaluation de la conformité par un tiers est toujours requise.

Les fournisseurs de systèmes d'IA à haut risque devront également mettre en œuvre des systèmes de gestion de la qualité et des risques afin de garantir qu'ils respectent les nouvelles exigences et de réduire au minimum les risques pour les utilisateurs et les personnes concernées, même après qu'un produit a été mis sur le marché. Les autorités de surveillance du marché contribueront à la surveillance des produits après leur mise sur le marché au moyen d'audits et en offrant aux fournisseurs la possibilité de signaler les incidents graves ou les manquements aux obligations en matière de droits fondamentaux dont ils viendraient à avoir connaissance.

L’application du règlement supervisé par des autorités nationales de surveillance et le comité européen de l'intelligence artificielle

La Commission européenne propose que les États membres jouent un rôle clé dans l'application et le contrôle du respect de ce règlement. À cet égard, chaque État membre devrait désigner une ou plusieurs autorités nationales compétentes pour surveiller l'application et la mise en œuvre des règles, ainsi que pour mener des activités de surveillance du marché. Pour permettre un gain d'efficience et garantir l'existence d'un point de contact officiel avec le public et les homologues, chaque État membre devrait désigner une autorité nationale de surveillance, qui sera également chargée de le représenter au sein du comité européen de l'intelligence artificielle.

Ce comité sera constitué de représentants de haut niveau des autorités nationales de surveillance compétentes, du Contrôleur européen de la protection des données et de la Commission européenne. Son rôle consistera à faire en sorte que la mise en œuvre du nouveau règlement sur l'IA soit aisée, effective et harmonisée. Le comité formulera des recommandations et des avis à l'intention de la Commission concernant les systèmes d'IA à haut risque et d'autres aspects pertinents pour la mise en œuvre effective et uniforme des nouvelles règles. Il contribuera également au développement de l'expertise et jouera le rôle de centre de compétences que les autorités nationales pourront consulter. Enfin, il apportera également son soutien aux activités de normalisation dans ce domaine.

Les sanctions prévues

En tant que règlement, le texte sera d'application directe, avec une portée extraterritoriale impliquant nombre d'acteurs non européens. La proposition de règlement sur la législation sur l’intelligence artificielle prévoit, en cas de mise sur le marché ou d'utilisation de systèmes d'IA qui ne respectent pas les exigences dudit texte, que les États membres devront prévoir des sanctions effectives, proportionnées et dissuasives, notamment des amendes administratives. Si une infraction est caractérisée, les États membres devront le communiquer à la Commission européenne. Plusieurs seuils d’amendes sont proposés :

- jusqu'à 30 millions d'euros ou 6 % du chiffre d'affaires annuel mondial total réalisé au cours de l'exercice précédent pour les infractions correspondant à des pratiques interdites ou à un non-respect des exigences relatives aux données ;

- jusqu'à 20 millions d'euros ou 4 % du chiffre d'affaires annuel mondial total réalisé au cours de l'exercice précédent en cas de non-respect d'une des autres exigences ou obligations prévues par la proposition de règlement ;

- jusqu'à 10 millions d'euros ou 2 % du chiffre d'affaires annuel mondial total réalisé au cours de l'exercice précédent si des informations inexactes, incomplètes ou trompeuses ont été fournies aux organismes notifiés ou aux autorités nationales compétentes en réponse à une demande.

La Commission européenne compte pouvoir s'appuyer sur l'avis du comité européen de l’intelligence artificielle sur pour élaborer des lignes directrices qui viseront notamment à harmoniser les règles et pratiques nationales en matière de fixation des amendes administratives. Afin de montrer l’exemple, les institutions, organes et agences de l'Union européenne devront se conformer aux règles et pourront faire l'objet de sanctions puisque le Contrôleur européen de la protection des données aura le pouvoir de leur infliger des amendes.

La mise en place de codes de conduite volontaires

La proposition de règlement sur la législation sur l’intelligence artificielle utilise des mécanismes de compliance. En effet, les fournisseurs d'applications qui ne sont pas à haut risque pourront garantir que leur système d'IA est digne de confiance en élaborant leur propre code de conduite volontaire, ou en adhérant au code de conduite d'une association représentative. Pour certains systèmes d'IA, ces codes de conduite volontaires s'appliqueront parallèlement aux obligations de transparence. La Commission européenne encouragera les associations du secteur et autres organisations représentatives à en adopter.

Le calendrier envisagé

Le Parlement européen espère trouver sa position sur la proposition de règlement de la Commission sur l’IA avant novembre 2022. Près de 3000 amendements ont été déposés par les groupes politiques du Parlement européen sur le projet de rapport de Dragoș Tudorache (Renew) et Brando Benifei (S&D) sur la proposition de règlement sur la législation pour l’intelligence artificielle. Les secrétariats des commissions Libertés civiles (Libe) et Marché intérieur (Imco) les ont transmis le 14 juin 2022 aux bureaux des eurodéputés impliqués. L’un des points clés de ces discussions concerne la reconnaissance faciale et la question de savoir si elle doit être interdite ou plutôt encadrée par des règles. Comme indiqué par Renaud Vedel, coordinateur national de l’IA, la France a joué un rôle actif dans la négociation de ce texte durant sa présidence de l’Union européenne. Le texte ne sera applicable que deux ans après son adoption à l’instar du règlement sur la protection des données à caractère personnel.

3. Des encadrements sectoriels prévus

Les machines et les équipements

Les risques systémiques découlant des systèmes d'intelligence artificielle peuvent justifier une approche verticale par secteurs. Ainsi, en complément de la proposition de règlement sur la législation sur l’intelligence artificielle, la Commission européenne a présenté une proposition de règlement relatif aux machines et produits connexes qui remplacera la directive du 17 mai 20106 2006/42/CE relative aux machines[9]. Cette proposition de règlement a pour objectif que les machines et équipements de nouvelle génération offrent toute la sécurité requise aux utilisateurs et aux consommateurs tout en encourageant l'innovation. La Commission européenne désigne par « machines et équipements » un large éventail de produits destinés aux particuliers ou aux professionnels, des robots (de nettoyage, de soin, collaboratifs, industriels), en passant par les tondeuses à gazon et les imprimantes 3D jusqu'aux engins de chantier et aux lignes de production industrielle. Ce texte et la proposition de règlement sur la législation sur l’intelligence artificielle sont complémentaires. En effet, le règlement sur la législation sur l’IA traitera des risques liés aux systèmes d'IA assurant les fonctions de sécurité des machines, tandis que le règlement relatif aux machines et équipements garantira, le cas échéant, l'intégration sûre du système d'IA dans la machine de façon à ne pas compromettre la sécurité de la machine dans son ensemble. La Commission européenne a indiqué que le champ d'application, les définitions et les exigences de sécurité du nouveau règlement relatif aux machines et aux équipements seront adaptés de façon à garantir une plus grande sécurité juridique et à tenir compte des nouvelles caractéristiques des machines. D'autres dispositions viseront aussi à garantir ce haut niveau de sécurité puisque des règles de classification seront fixées pour les machines à haut risque. Ainsi, les machines ayant subi une modification substantielle seront soumises à une évaluation de la conformité.

Les travailleurs des plateformes

En outre, certains services d’intelligence artificielle ont recours aux travailleurs des plateformes. Or la Commission européenne a également présenté en décembre 2021 un ensemble de mesures visant à améliorer les conditions de travail dans le cadre du travail via une plateforme et à promouvoir une croissance durable des plateformes de travail numériques dans l'Union européenne[10]. En particulier, la Commission européenne a publié une communication exposant l'approche de l'UE et ses mesures en matière de travail via une plateforme ainsi qu’une proposition de directive relative à l'amélioration des conditions de travail dans le cadre du travail via une plateforme. Celle-ci prévoit des mesures visant à déterminer correctement le statut professionnel des personnes travaillant par l'intermédiaire de plateformes de travail numériques et consacre de nouveaux droits tant pour les travailleurs salariés que pour les travailleurs indépendants en ce qui concerne la gestion algorithmique.

Pour aller plus loin :

4. Et à l’international ?L’Organisation des Nations unies pour l'éducation, la science et la culture a publié en novembre 2021 des recommandations sur l’éthique de l’intelligence artificielle[11]. Pareillement, les principes de l’Organisation de coopération et de développement économiques (OCDE) sur l’intelligence artificielle promeuvent une IA innovante et digne de confiance, qui respecte les droits humains et les valeurs démocratiques. Ils ont été adoptés en mai 2019 par les pays membres de l’OCDE, lorsque ces derniers ont approuvé la recommandation du Conseil sur l’intelligence artificielle[12]. |

[1] COMMUNICATION DE LA COMMISSION AU PARLEMENT EUROPÉEN, AU CONSEIL EUROPÉEN, AU CONSEIL, AU COMITÉ ÉCONOMIQUE ET SOCIAL EUROPÉEN ET AU COMITÉ DES RÉGIONS L'intelligence artificielle pour l'Europe, COM(2018)237, juin 2018, https://ec.europa.eu/transparency/documents-register/detail?ref=COM(2018)237&lang=fr.

[2] GROUPE D’EXPERTS INDÉPENDANTS DE HAUT NIVEAU SUR L’INTELLIGENCE ARTIFICIELLE CONSTITUÉE PAR LA COMMISSION EUROPÉENNE EN JUIN 2018, Lignes directrices en matière d’éthique pour une IA digne de confiance, Publications Office, 2019, https://data.europa.eu/doi/10.2759/54071.

[3] GROUPE D’EXPERTS INDÉPENDANTS DE HAUT NIVEAU SUR L’INTELLIGENCE ARTIFICIELLE CONSTITUÉE PAR LA COMMISSION EUROPÉENNE EN JUIN 2018, op. cit., p. 3.

[4] COMMISSION EUROPÉENNE, LIVRE BLANC Intelligence artificielle - Une approche européenne axée sur l'excellence et la confiance, COM(2020) 65 final, février 2020, https://ec.europa.eu/info/sites/default/files/commission-white-paper-artificial-intelligence-feb2020_fr.pdf.

[5] Livre blanc préc., p. 19.

[6] CRICHTON Cécile, “Publication par la Commission de son Livre blanc sur l’intelligence artificielle”, Dalloz actualités, février 2020, https://www.dalloz-actualite.fr/flash/publication-par-commission-de-son-livre-blanc-sur-l-intelligence-artificielle#.YiDhay3pNQI.

[7] COMMISSION EUROPÉENNE, Proposition de RÈGLEMENT DU PARLEMENT EUROPÉEN ET DU CONSEIL ÉTABLISSANT DES RÈGLES HARMONISÉES CONCERNANT L’INTELLIGENCE ARTIFICIELLE (LÉGISLATION SUR L’INTELLIGENCE ARTIFICIELLE) ET MODIFIANT CERTAINS ACTES LÉGISLATIFS DE L’UNION, COM/2021/206 final, avril 2021.

[8] Avis conjoint 05/2021 de l’EDPB et du CEPD sur la proposition de règlement du Parlement européen et du Conseil établissant des règles harmonisées concernant l’intelligence artificielle (législation sur l’intelligence artificielle), juin 2021, https://edps.europa.eu/system/files/2021-10/2021-06-18-edpb-edps_joint_opinion_ai_regulation_fr.pdf. Pour une synthèse de l’avis : CNIL, Intelligence artificielle : l’avis de la CNIL et de ses homologues sur le futur règlement européen, juillet 2021,https://www.cnil.fr/fr/intelligence-artificielle-lavis-de-la-cnil-et-de-ses-homologues-sur-le-futur-reglement-europeen.

[9] COMMISSION EUROPÉENNE, Proposition de RÈGLEMENT DU PARLEMENT EUROPÉEN ET DU CONSEIL sur les machines et produits connexes, COM(2021) 202 final, avril 2021, https://eur-lex.europa.eu/legal-content/FR/TXT/HTML/?uri=CELEX:52021PC0202&from=EN.

[10] COMMISSION EUROPÉENNE, “Propositions de la Commission pour améliorer les conditions de travail des personnes travaillant via une plateforme de travail numérique”, communiqué de presse, décembre 2021, https://ec.europa.eu/commission/presscorner/detail/fr/ip_21_6605.

[11] UNESCO, Recommandation sur l’éthique de l’intelligence artificielle, SHS/BIO/REC-AIETHICS/2021, 2021, 21 p., https://unesdoc.unesco.org/ark:/48223/pf0000380455_fre.

[12] OCDE, page sur l’intelligence artificielle : https://www.oecd.org/fr/numerique/intelligence-artificielle/.