"Intelligence artificielle et société” - Colloque du 22 juin 2022

Le 22 juin 2022 s’est tenu le colloque inaugural de l’Observatoire de l’Intelligence artificielle de l’université Paris 1 Panthéon-Sorbonne (AI Obs).

INTRODUCTION DE LA JOURNÉE

Le discours d'ouverture

La journée a été introduite par Madame Christine Neau-Leduc, Professeure d'université et Présidente de l’université Paris 1 Panthéon-Sorbonne. Elle a salué le caractère fédérateur du projet : « Cet observatoire va explorer les richesses et l’excellence de la recherche et de la formation au sein de notre université. Les enseignants s’inscrivent ainsi dans les enjeux d’aujourd’hui pour préparer l’avenir de nos étudiants et de nos chercheurs. […] À l’image de notre université, l’interdisciplinarité et l’ouverture à l’international font partie de l’ADN de cet observatoire. »

(Le discours en intégralité ici)

"Veiller au respect des droits et des libertés à l'ère de l'Intelligence artificielle"

Puis Madame la Défenseure des Droits, Claire Hédon, a livré un discours intitulé “Veiller au respect des droits et des libertés à l'ère de l'Intelligence artificielle”. Elle a notamment souligné que : « cet observatoire s’inscrit tout à fait dans la lignée de nos recommandations en matière d'intelligence artificielle. Le lancement d’un observatoire français va contribuer à mieux renseigner les multiples enjeux que soulève l’IA, à la fois à l’échelle nationale mais aussi à l’échelle européenne. »

(Le discours en intégralité ici)

La présentation de l'Observatoire de l'Intelligence artificielle de l'université Paris 1 Panthéon-Sorbonne

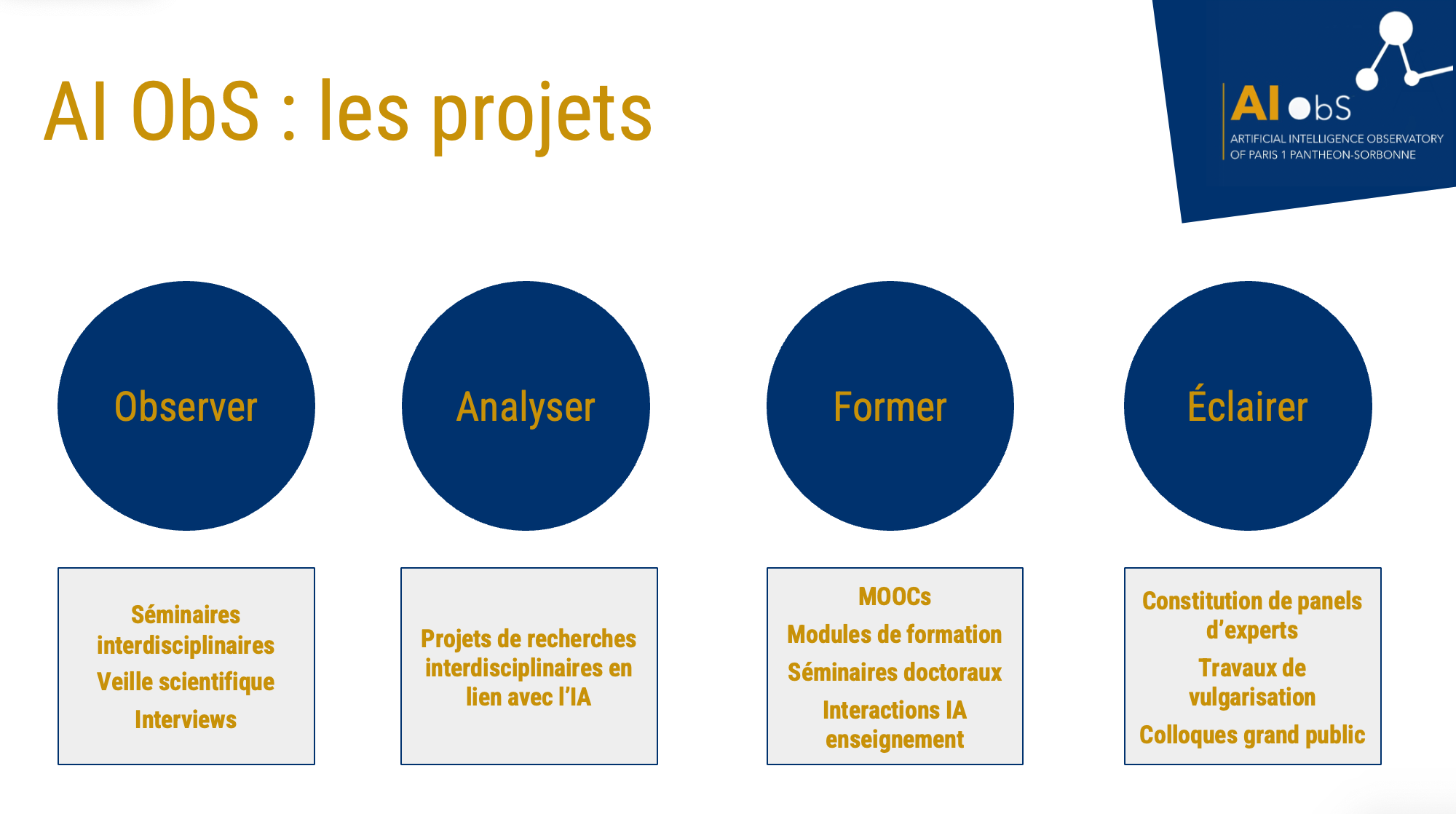

Les porteurs de l’observatoire, Alain Celisse, Professeur de mathématiques appliquées, Stéphane Lamassé, Maître de conférences en histoire et humanités numériques et Célia Zolynski, Professeure de droit privé à l’université Paris 1 Panthéon-Sorbonne ont ensuite présenté les grandes missions de l’observatoire. Déclinées en quatre objectifs - observer, analyser, former et éclairer -, ces missions s’inscrivent dans une dynamique interdisciplinaire et fédératrice.

(La présentation de l'observatoire en intégralité ici)

Lire aussi : "Observer, analyser, former, éclairer : l’université lance son Observatoire de l’Intelligence artificielle".

QUEL SENS DONNER À L’INTELLIGENCE ARTIFICIELLE ?

La première partie de la matinée invitait les intervenants à livrer leurs analyses sur le sens à donner à l’intelligence artificielle.

Animant ces débats, Alberto Naibo, Maître de conférences en philosophie à l’université Paris 1, a souligné combien cette interrogation éveille immédiatement l’attention compte tenu de la polysémie du mot « sens ». En premier lieu, il renvoie à la question de la signification, à la manière de comprendre ce qu’est l’intelligence artificielle. Il a ainsi indiqué que si les systèmes d’intelligence artificielle sont des techniques, ils sont aussi des instruments employés en vue de l’obtention de certains résultats. Dès lors, il est nécessaire de comprendre ces usages et leurs implications. En second lieu, l’expression “Donner un sens à l'intelligence artificielle” implique d’assigner une valeur à ces instruments et en orienter l’usage. Ainsi, comprendre quelles sont les directions que l’intelligence artificielle a prises ou qu’elle peut prendre dans le futur est une autre manière de comprendre la question « quel sens donner à l’intelligence artificielle ». L’expression Donner un sens à l'intelligence artificielle est enfin le titre du rapport confié au mathématicien et député Cédric Villani remis en mars 2018 et auquel a largement contribué Yann Bonnet.

Le rapport Villani, 5 ans après

Ingénieur de formation et actuellement directeur général du Campus Cyber, Yann Bonnet a été secrétaire général du Conseil national du numérique jusqu'en mai 2018. En 2017, il a accompagné Cédric Villani dans sa mission sur l'intelligence artificielle confiée par le Premier Ministre. Il a rappelé que le rapport de la mission a permis de définir la stratégie de la France sur l'IA avant de présenter sa vision du déploiement et des analyses des systèmes d’IA près de 5 ans après la remise de ce rapport au Président de la République.

(La présentation des suites du rapport en intégralité ici)

La table-ronde "Autorités publiques et pensée critique sur l'IA"

Une table ronde était ensuite consacrée au rôle et analyses des autorités publiques pour construire une pensée critique sur l’IA, animée par la Professeur de droit Martine Behar-Touchais. Depuis plus de cinq ans, les autorités et les commissions indépendantes publiques françaises ont développé une pensée critique dense autour des enjeux sociaux de l’intelligence artificielle. Les premières réflexions étaient principalement des réflexions éthiques qui préfigurent bien souvent le droit ; les garanties à apporter aux droits fondamentaux sont également au cœur des débats. Ceci ressort des travaux menés ces dernières années tant par la Commission nationale de l’informatique et des libertés (CNIL), le Conseil national du numérique, le Comité national pilote d’éthique du numérique, le Défenseur des droits ou encore la Commission nationale consultative nationale des droits de l’homme (CNCDH).

Félicien Vallet, adjoint au chef du service de l’expertise technologique et responsable IA à la Commission Nationale de l'Informatique et des Libertés (CNIL) est chargé de coordonner les actions liées à l'Intelligence Artificielle de manière transversale au sein de l'autorité française de protection des données. Il a présenté les actions de cette dernière menées depuis ses travaux de 2017 sur les enjeux éthiques des algorithmes et de l’IA.

Avocat de formation, Gaëtan Goldberg est chargé de mission numérique, droits et libertés au sein de la Direction de la promotion de l’égalité et de l’accès aux droits du Défenseur des droits où il pilote les travaux de l’institution en lien avec l’intelligence artificielle. Il a présenté l’avis du réseau Equinet (réseau européen des organismes de promotion de l’égalité) portant sur le projet de règlement de la Commission européenne sur l’IA.

Puis, Claude Kirchner, Directeur de recherche de l’Institut national de recherche en sciences et technologies du numérique et président du Comité pilote d’éthique du numérique, instance placée sous l’égide du Comité consultatif national d’éthique pour mener des réflexions sur les enjeux d’éthique du numérique et de l’IA, a livré son interprétation concernant les enjeux éthiques liés aux usages du numérique en contexte de crise sanitaire et plus largement s’agissant de l’éthique du numérique.

Par la suite, Lucien Castex, chercheur associé à l’Université Sorbonne-Nouvelle et membre de l’ISOC, qu’il représente en qualité de membre au sein de la Commission nationale consultative des droits de l’homme (CNCDH), a présenté les principales recommandations de l’avis “Intelligence artificielle et droits humains : Pour l’élaboration d’un cadre juridique ambitieux” publié en avril 2022 par la CNCDH.

Enfin, est intervenu lors de cette table-ronde Eric Salobir, membre du Conseil national du numérique et fondateur du réseau OPTIC qui vise à promouvoir le développement des technologies au service de l’humain et du bien commun. Il est revenu sur les travaux du Conseil national du numérique relatifs à l’intelligence artificielle et à la démocratie.

(La table-ronde en intégralité ici)

Lire aussi : L'entretien croisé avec Bertrand Pailhès et Félicien Vallet, agents de la CNIL.

Lire aussi : L'entretien avec Claude Kirchner sur l'éthique du numérique.

"L'IA et l'Europe : quelle "troisième voie" ?"

Alberto Naibo a rappelé que par “troisième voie de l’IA”, il faut entendre la voie promue par l’Union européenne face aux puissances économiques américaine et chinoise. Depuis 2018, la Commission européenne a proposé deux stratégies et deux livres blancs afin de permettre un développement “sûr et digne de confiance” (selon l’expression consacrée par l’Union européenne) de l’intelligence artificielle en Europe, dans le plein respect des valeurs et des droits des citoyens européens. Dans ce cadre, l’intervention de Renaud Vedel a permis de présenter la stratégie sur l'intelligence artificielle qui s’est dessinée progressivement en France et en Europe. Ensuite, Grégoire Loiseau et Philippe Besse ont livré leurs analyses de la proposition de règlement sur la législation sur l’intelligence artificielle.

La stratégie nationale pour l’IA

Renaud Vedel est préfet depuis 2012. Après 20 ans d’action publique centrée sur les politiques territoriales, les politiques de sécurité et le renseignement, il s’est spécialisé sur les politiques publiques numériques depuis 2018 et coordonne depuis 2020 la Stratégie nationale pour l'IA. Lors de sa présentation, il a exposé quelle est la vision stratégie française et européenne de l’IA. Il a ainsi rappelé que, depuis 5 ans, l'IA a fait irruption comme paradigme technologique majeur et comme terrain de rivalité entre les Nations. La France et l'Europe sont engagées dans un vaste mouvement de régulation du numérique pour s'assurer que son développement respecte les valeurs éthiques et les règles juridiques du continent. Elles doivent toutefois équilibrer régulation et stimulation de l'innovation pour prévenir tout risque de décrochage dans un domaine qui pourrait constituer une nouvelle "technologie d'usage général" et appartenir à la matrice de la quatrième révolution industrielle.

Lire aussi : L'entretien avec le Préfet Renaud Vedel sur la stratégie nationale pour l'IA.

Analyses sur la proposition de règlement sur la législation sur l’intelligence artificielle

Les stratégies française et européenne ont servi de base pour l’élaboration du premier cadre juridique sur l'intelligence artificielle. En effet, la Commission européenne a dévoilé en avril 2021 sa proposition de règlement établissant des règles harmonisées concernant l’intelligence artificielle aussi dite légalisation sur l’intelligence artificielle et modifiant certains actes législatifs de l’Union européenne. Grégoire Loiseau, Professeur de droit à l’École de droit de Paris 1 et spécialiste de droit social et droit civil qui s’intéresse depuis plusieurs années à la construction d’un droit de ou pour l’intelligence artificielle, a expliqué son analyse juridique de la proposition de règlement concernant l’Intelligence artificielle.

Professeur émérite de mathématiques et statistiques à l'Institut national des sciences appliquées, membre de l’Institut de mathématiques de Toulouse et chercheur régulier à l'Observatoire International sur les Impacts Sociétaux de l'IA et du Numérique (OBVIA) au sein de l’Université Laval Québec, Philippe Besse a ensuite présenté son analyse des principaux risques des impacts sociétaux de l'IA et en particulier des discriminations algorithmiques. Concernant la réglementation européenne à venir, il a plus particulièrement exposé les enjeux relatifs aux audits qui sont prévus notamment afin de détecter ces risques.

(La séquence en intégralité ici)

POUR UNE APPROCHE RÉFLEXIVE DE L’IA

La deuxième partie du colloque était animée par Cécile Faliès, Maître de conférences en géographie et Vice-présidente Recherche et Camille Salinesi, Professeur en informatique et Vice-président des relations internationales de l’université Paris 1 Panthéon-Sorbonne. Deux projets de recherche ont été ainsi présentés dans la mesure où ils reflètent l'excellence de la recherche sur l’IA au sein de l’université Paris 1.

Le projet e-NDP Notre Dame de Paris et son cloître

Le projet ANR e-NDP "Notre-Dame de Paris et son cloître" a été le premier projet présenté par Julie Claustre Mayade, Maître de conférences en histoire à Paris 1 et Sergio Torres Aguilar, post-doctorant à l’Ecole nationale des chartes. Ce projet est porté par le LaMOP, en partenariat avec les Archives nationales, la Bibliothèque nationale de France, l’École nationale des Chartes et la Bibliothèque Mazarine. Il s’inscrit dans l’environnement de recherche qui s’est formé après l’incendie de Notre-Dame et porte sur la documentation textuelle liée à l’histoire de la cathédrale. Le recours au système d’IA permet alors d’augmenter les copies de lecture et de traitement des corpus réunis. Julie Claustre Mayade et Sergio Torres Aguilar ont éclairé le public sur la place de l’IA dans leur projet et en quoi cela leur permet d’entrevoir Notre Dame comme jamais elle n’a été vue.

(La présentation du projet en intégralité ici)

Lire aussi : L’entretien de Julie Claustre Mayade sur le projet e-NDP.

La chaire Pluralisme culturel et éthique du numérique

Joëlle Farchy, en qualité de professeur en sciences de l’information et de la communication à l’université Paris 1, spécialiste des industries culturelles et de l'économie numérique, a présenté la Chaire “Pluralisme culturel et éthique” créée en 2020 au sein de la Fondation Panthéon–Sorbonne de l’Université Paris 1. Co-portée par l’université Paris 2 Panthéon-Assas, cette Chaire se donne pour objectif d'être un pôle d'échanges et de recherches pluridisciplinaires. Ses projets se construisent autour de deux axes : la diversité et la qualité des contenus culturels et médiatiques en ligne, et les problématiques éthiques des algorithmes et du numérique. Joëlle Farchy a expliqué les projets qui sont portés par la chaire et ses méthodologies de recherche. Elle a aussi présenté des applications de l'intelligence artificielle dans les industries culturelles.

Consultez le site de la chaire : https://pcen.fr/.

La table-ronde " Intelligence artificielle, désinformation et démocratie : regards croisés"

La dernière table-ronde de la journée se voulait interdisciplinaire, sur un sujet emblématique des enjeux sociaux de l’IA : celui de la désinformation et de la démocratie. Alain Celisse et Célia Zolynski, qui animaient cette table ronde, ont échangé avec :

- Emmanuel Didier (sociologue et directeur de recherche CNRS-ENS),

- Christine Dugoin-Clément (chercheuse associée à la Chaire “Risques” IAE Paris-Sorbonne Business School, université Paris 1 & CREOGEN),

- Joséphine Hurstel (responsable des études au Conseil national du numérique),

- Marion Vorms (Maître de conférences en philosophie à l’université Paris 1).

Les différents panélistes ont présenté les mécanismes de la désinformation, les outils technologiques utilisés pour la mettre en œuvre ou la détecter, et les stratégies possibles pour la contrer, que ce soit d’un point de vue technique, stratégique, éthique ou encore philosophique. Alain Celisse a commencé par décrire brièvement quelques mécanismes technologiques qui sont couramment mis en œuvre en matière de désinformation, en particulier en lien avec l’Intelligence artificielle. Joséphine Hurstel, a ensuite présenté les travaux menés dans le cadre du dossier du CNNum intitulé "Récits et contre-récits. Itinéraire des désinformations", particulièrement les dimensions écosystémique et économique des mécanismes de désinformation en précisant la place de l’IA à cet égard. Christine Dugoin-Clément est ensuite intervenue pour inscrire le problème de la désinformation dans un cadre plus général : celui des stratégies d’influence pour manipuler la prise de décision voire d’une guerre électronique informationnelle entre groupes d’influence. Compte tenu de son expertise en matière de stratégies informationnelles, elle a expliqué comment l’IA est mise à contribution dans ces mécanismes d’influence, s’agissant des groupes sociaux et individuels et comment cela a créé des polarités. En tant que philosophe, Marion Vorms a fait le lien entre les interventions et ses travaux sur la crédulité. Elle a notamment mis en lumière le mécanisme qui fait qu’une personne peut “basculer” dans la croyance en une information sans pour autant que celle-ci soit avérée.

La table-ronde a aussi été l'occasion d’évoquer les solutions mises en place pour contrer la désinformation. En effet, depuis quelques années, nombre d’acteurs de la vie publique ont développé des cellules de vérification de l’information (appelées Fact-checkers). Emmanuel Didier, en sa qualité de sociologue, a mené des travaux en collaboration avec le journal Le Monde et leur service “Les Décodeurs”. Il a expliqué les stratégies développées par ces cellules pour vérifier une information et ses limites éventuelles. Joséphine Hurstel a ensuite présenté les mécanismes mis en œuvre par les plateformes pour lutter contre la désinformation et précisé leurs limites.

Les panélistes ont enfin discuté des contre-récits et de la manière de redonner de l’autorité aux récits, discours et faits. Ils ont ainsi échangé sur la place du discours scientifique dans notre société. Ils ont en outre évoqué la nécessité de former dès le plus jeune âge aux usages du numérique dès lors que “nos capacités cognitives peuvent être altérées par les réseaux sociaux et les “appareils intelligents”, comme le souligne notamment l’OTAN dans le cadre de son programme “Countering cognitive warfare: awareness and resilience”.

(La table-ronde en intégralité ici)

Quelle pédagogie pour l’IA ?

Le dernier temps fort du colloque portait sur la question de déterminer “Quelle pédagogie pour l’IA ?”

Le MOOC UNA EUROPA "AI in Society"

Le constat est fait que l’éducation du plus grand nombre de personnes possibles sur les technologies et les impacts sociaux de l’intelligence artificielle est une vraie nécessité. C’est la raison pour laquelle Paris 1 a rejoint l’Université d’Helsinki dans la création du MOOC “AI in Society” qui a été présenté par Tomi Kokkonen, chercheur en philosophie de cette université finlandaise.

(La présentation du MOOC en intégralité ici)

Voir aussi : MOOC AI in society.

Les projets de l'Observatoire de l'IA de Paris 1

Pour clôturer cette journée de colloque, Alain Célisse, Stéphane Lamassé, Camille Salinesi et Célia Zolynski ont présenté les projets qui seront menés au sein de l’Observatoire de l’IA de Paris 1, pensé comme un carrefour pour les enseignants-chercheurs en sciences humaines et sociales, et qui s’articule autour de quatre missions :

- observer les principaux concepts qui structurent la recherche sur l'IA pour initier de nouvelles dynamiques interdisciplinaires ;

- analyser les nouveaux comportements émergents en lien avec un usage massif de l’IA ;

- former par la production d’outils de compréhension dans le domaine de l’IA et en lien avec différentes disciplines ;

- éclairer les politiques publiques et sensibiliser le public aux enjeux de l’IA.