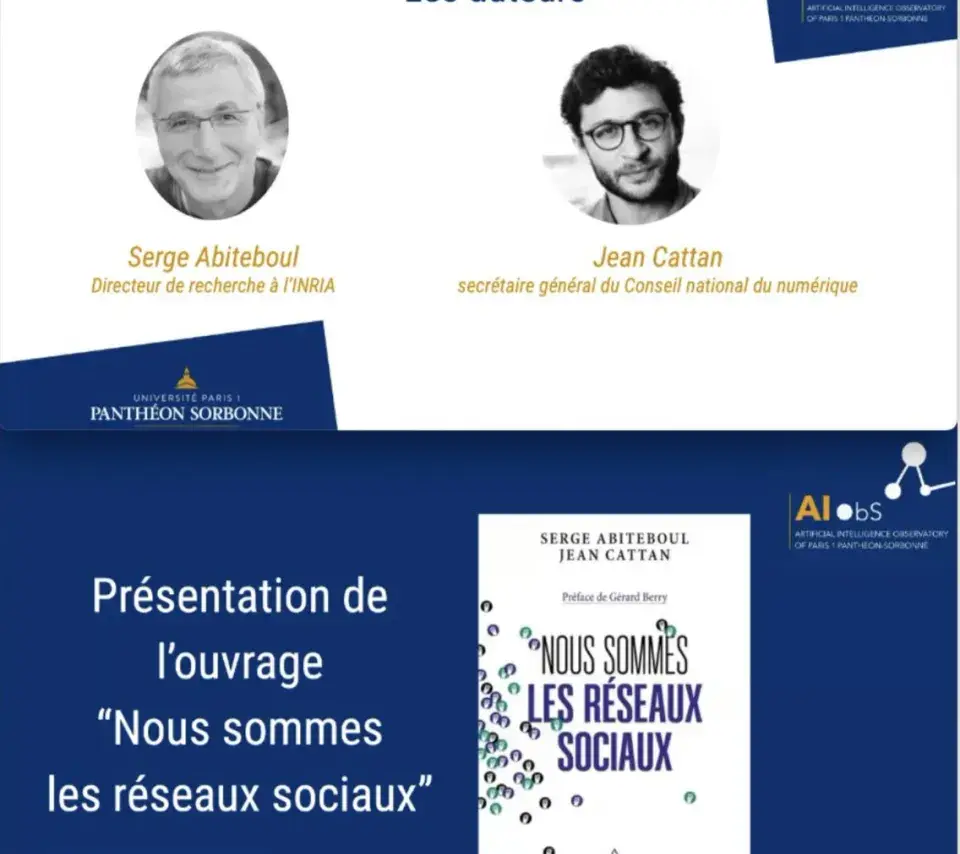

Entretien avec les auteurs de l’ouvrage "Nous sommes les réseaux sociaux"

Serge Abiteboul, directeur de recherches à l’Inria (Institut national de recherche en sciences et technologies du numérique) et Jean Cattan, secrétaire général du Conseil national du numérique et docteur en droit sont les auteurs de l’ouvrage “Nous sommes les réseaux sociaux” paru aux éditions Odile Jacob, préfacé par Gérard Berry.

Ils soutiennent que les réseaux sociaux ne se substituent pas à nos liens sociaux mais les transforment profondément. S’ils s’appuient sur des techniques brillantes de l’informatique, des infrastructures complexes et des modèles économiques aussi astucieux que pernicieux, leur richesse première reste les humains qui construisent ces liens. Pour l’Observatoire de l’intelligence artificielle de l’Université Paris 1 Panthéon-Sorbonne, ils ont accepté de présenter leur ouvrage.

S. Abiteboul et J. Cattan, Nous sommes les réseaux sociaux, Odile Jacob éd., sept. 2022, 256 pp.

Les réseaux sociaux et la place des systèmes d’IA dans leur développement

Serge Abiteboul : Nous revenons sur l’histoire et la polymorphie des réseaux sociaux dans le premier chapitre de notre ouvrage. D’une certaine manière, on peut considérer qu’un réseau social numérique est une base de données avec des interfaces utilisateurs pour entrer des contenus et gérer les comptes d’utilisateurs. Ces réseaux sociaux existent depuis moins de vingt ans. Ainsi, après le succès de MySpace, d’autres plateformes sont apparues dont Facebook (plutôt orienté vers les liens d’"amitiés" et d’affinités et cumulant 3 milliards d’utilisateurs), Twitter (microblog public), YouTube (partage de vidéos), Instagram, TikTok et Snapchat (médias visuels) ou encore LinkedIn (contacts professionnels). On peut citer d’autres plateformes qui diversifient considérablement ce type de réseautage comme Twitch (livestream), Reddit (échanges par communautés d’intérêts), WT.Social (partage d’information se voulant non toxique) ou encore Mastodon (désormais fameux, décentralisé et aux mains des utilisateurs).

D’un point de vue social, les réseaux sociaux formalisent le passage dans l’environnement numérique de choses qui existent déjà dans la vie réelle. D’un point de vue technique, il n’y a pas de vraie invention : il s’agit en effet de réutilisations de technologies qui ont fait leurs preuves, par exemple, dans les moteurs de recherche sur la toile à l’instar de la communication et du stockage de données. La grande difficulté est de parvenir à stocker les données de milliards de personnes et à répondre à chaque instant à des millions de requêtes, ce qui est résolu en utilisant le parallélisme massif.

Les systèmes d’intelligence artificielle (SIA) sont utilisés à trois niveaux avec des niveaux d'importance plus ou moins marqués. En premier lieu, les SIA aident à la recommandation et l'ordonnancement des réponses. Il s’agit des technologies qui permettent de mettre en visibilité certains contenus plutôt que d’autres. Des techniques de recommandation semblables sont utilisées dans les moteurs de recherche pour classer les résultats dans les services de vidéo à la demande. Cependant, il s’agit davantage d’analyse de données statistiques, autrement dit de Big data, que de l'utilisation de SIA. Chaque réseau social dispose alors de sa propre façon de recommander des contenus.

En deuxième lieu, les systèmes d’IA interviennent dans la gestion de la publicité. Il s’agit du nerf de la guerre pour les réseaux sociaux puisque leurs ressources en dépendent quasiment entièrement. Il faut bien comprendre que l’intérêt des réseaux sociaux est de satisfaire d'abord les entreprises qui paient de la publicité. Pour ce faire, des techniques assez sophistiquées ont été développées notamment avec des systèmes d'enchères afin d’acheter la publicité sur certains mots.

Enfin, les SIA sont utilisés pour la modération de contenus, par exemple pour détecter des contenus haineux ou agressifs. Les contenus à retirer peuvent être des contenus illicites tels que des contenus terroristes, mais également des contenus interdits par les conditions d’utilisation des plateformes, comme les contenus de nudité. Les résultats ne sont pas exceptionnels, mais ne s'avèrent pas plus mauvais que ce que font les humains. L’utilisation des SIA dans la modération des contenus s’est généralisée depuis la crise sanitaire. C’est dans le système de modération que l’utilisation des SIA est la plus originale.

Dans notre ouvrage, nous considérons que la manière dont la modération des contenus est réalisée constitue un sujet sociétal majeur. Plusieurs approches sont possibles. Tout d’abord, celle de l’autorégulation c’est-à-dire que le réseau social reste plus ou moins seul en charge de la modération des contenus problématiques. À l’opposé, les gouvernements peuvent décider de la modération des contenus. C’est le cas dans les pays totalitaires comme la Chine ou la Russie. Enfin, on peut défendre l’existence d’une troisième voie qui est celle empruntée par l’Union européenne dans ses nouveaux textes, comme le DMA et le DSA. Cette voie consiste à reconnaître que réseau social peut lui-même effectuer la modération des contenus, mais de manière supervisée et définie par la société.

Jean Cattan : Nous rappelons aussi dans notre ouvrage que ce sont d’abord les données personnelles des utilisateurs, voire de personnes qui ne sont pas inscrites sur les réseaux sociaux, qui forment la richesse des réseaux sociaux. En outre, certains réseaux choisissent des contenus à la place des utilisateurs avec un phénomène constaté de personnalisation du contenu au-delà du choix de l’utilisateur et à des degrés variés. Prenons le fonctionnement de TikTok : il existe dans ce cas particulier une relation quasiment personnelle qui se tisse entre le réseau social et l'utilisateur en mettant en avant des contenus qui viennent non pas des personnes suivies, mais essentiellement d’autres horizons. Dès lors, il y a une sorte de connivence entre le réseau et l’individu qui se tisse, oscillant entre des zones de découvertes et de familiarités avec des propositions de contenus. Sans que l’on sache exactement comment ces choix sont opérés par la plateforme ou que l’on sache dire à quel point ces techniques sont sophistiquées ou relèvent d’un mélange plus ou moins ingénieux entre statistique et hasard. À l’inverse de TikToK, Reddit fonctionne par exemple sur des entrées thématiques et il y a une pondération selon les appréciations positives ou négatives des utilisateurs notamment, plutôt que de l’informatisation du contenu en lui-même. Ce qui change du tout au tout la place laissée à de potentiels outils algorithmiques. Enfin, le cas de Mastodon nous montre que ce que l’on appelle l’intelligence artificielle peut avoir un rôle réduit à une portion congrue. On se retrouve d‘abord avec des contenus qui viennent de notre instance classés essentiellement de manière chronologique et sans que le contenu soit proposé par le réseau social.

Ces degrés différents de marges de manœuvre laissées aux utilisateurs font qu'il est difficile d’avoir une réponse uniforme quant au rôle joué par telle ou telle technologie dans le fonctionnement des réseaux sociaux dans leur ensemble : la capacité de ces derniers à s’adapter à la volonté des utilisateurs étant précisément un facteur de différenciation. Quelle place est laissée à l’aléa ? À l'individu ? À la communauté ? Il faut donc nuancer le rôle des systèmes dits d’intelligence artificielle dans la proposition des contenus.

Serge Abiteboul : Une des clefs du succès des réseaux sociaux devient alors la personnalisation, notamment pour trouver les informations que vous cherchez ou ce que vous aimez bien. Le fait de présenter une pizza dans votre localité et non la meilleure pizza au monde, peut-être à Chicago, découle de la personnalisation. Cela correspond à un désir des utilisateurs : on cherche des choses qui sont proches de nos goûts comme un abonnement pour un journal. La personnalisation est la clef de la réussite des réseaux sociaux et elle repose sur des SIA.

Les SIA et la modération des contenus

Jean Cattan : Plusieurs chapitres de Nous sommes les réseaux sociaux sont dédiés à la modération. La modération vise à chercher un équilibre entre la liberté d'expression et la protection contre des contenus illicites ou indésirables. Entre les contenus manifestement illicites et les contenus acceptables se déploient des contenus situés dans une "zone grise" dans laquelle le réseau social a une marge de manœuvre pour décider ce qu’il laisse prospérer ou non. Dès règles propres à chaque réseau social précisent leur choix, à l’image des community standards de Facebook.

Dès lors, quelle place faut-il réserver pour les outils dits d’intelligence artificielle dans la modération ou l’identification des contenus illicites ? Il faudrait encourager une mise en commun des moyens techniques contre les contenus les plus problématiques avant que les contenus ne soient diffusés et soient viraux. Le Global Internet Forum to Counter Terrorism permet déjà de partager des clefs d’identification de vidéos qualifiées comme faisant l’apologie ou exposant des faits de terrorisme. Il y a donc des règles collectives qui émergent. Il faut désormais une mutualisation des outils, des principes et des règles sur lesquels on souhaite dicter nos choix. À condition bien sûr que ces règles ne soient pas définies par une poignée d’acteurs économiques surpuissants.

Serge Abiteboul : Il n’est pas évident de savoir ce que l’on veut modérer. La modération des contenus sur les réseaux sociaux s’opère sur plusieurs niveaux comme j’ai pu le découvrir lors de la mission dite Facebook sur la régulation des réseaux sociaux demandée par le Président de la République. En premier lieu, un groupe de personnes spécifie ce que l’on veut bloquer. Des règles sont donc définies pour expliquer de façon très pratique les concepts et les verbes mis en jeu pour retirer ou laisser un contenu. Le deuxième niveau consiste à prendre des exemples concrets pour permettre de mieux identifier les contenus à retirer ou à laisser. Ces exemples servent d'illustrations pour les modérateurs humains qui seront formés en deux à trois semaines, mais également à entraîner des algorithmes d’intelligence artificielle visant à modérer les contenus. Il faut donc construire des corpus massifs de contenus associés à des décisions. Ce niveau de modération est réalisable pour des grandes entreprises, mais les petites entreprises n’ont pas les moyens de réaliser le même niveau de modération.

Il faudrait donc considérer que ces corpus de données constituent des données d’intérêt général pour éviter que la modération ne devienne un frein d'entrée dans le marché. Les règles qui guident la modération doivent également être discutées sur la place publique et construites véritablement sur un socle sociétal. Pour autant, cela ne va pas nécessairement conduire à une uniformisation de la modération puisqu’il s’agit de se mettre d'accord sur les concepts. Cela ne signifie pas nécessairement que la société doit fonctionner avec le même système de modération et avec les mêmes règles de modération pour tous les réseaux sociaux et tous les individus.

Dans certains cas, il est important de réaliser un travail collectif pour se mettre d’accord sur des règles de modération comme ce qui a été fait pour le terrorisme. Ce n’est pas nécessaire dans tous les domaines. Tous les réseaux sociaux n’ont pas besoin de prendre les mêmes règles et la même définition de la liberté d’expression. Toutefois, il serait possible de se mettre d’accord sur des termes et les modalités de caractérisation des contenus. Ensuite, nul besoin de modérer les contenus de la même façon. Certains réseaux sociaux pourraient choisir une liberté d’expression à l'américaine, d’autre préférer celle à l’européenne, mais en s’appuyant sur des concepts communs.

Bien entendu, c’est complexe parce que cela relève de la langue et que cela doit s’appliquer dans de nombreux pays qui ne partagent pas la même langue et la même culture. D’ailleurs, la modération est très inégale en fonction des lois, mais aussi des langages. Cela conduit à impliquer un très grand nombre de participants. Chacun devrait pouvoir discuter, catégorie par catégorie, des contenus à retirer ou non. Il ne s’agit pas forcément de faire de tout le monde un régulateur ou un modérateur, mais de permettre à chaque communauté, à chaque zone géographique, à chaque aire linguistique de s'approprier les questions de la modération. Cela n’est pas si utopique quand on considère que les standards de la communauté peuvent être assurés par les contributeurs eux-mêmes comme c’est déjà le cas sur les pages de discussions de Wikipédia. Le réseau social qui a été créé par Jimmy Wales, fondateur de Wikipédia, fonctionne de la sorte : il s'appelle WT.Social et il a précisément pour vocation de proposer aux utilisateurs un réseau social tourné vers l'information et non toxique.

La capture de l’attention par les réseaux sociaux

Serge Abiteboul : Les choix de présentation des réseaux sociaux influent également sur la modération. Mais la modération n’est pas leur objectif. Ils modèrent surtout pour ne pas perdre des utilisateurs. Leur but principal est de capturer l'attention de ces utilisateurs.

Concernant la capture de l’attention, il me semble que le point fondamental est un problème d’éducation. Il faut que collectivement on s'habitue à consommer et à produire des contenus. Prenons le problème des fake news : elles sont propagées par des bots qui peuvent être régulés, mais également par des personnes. Il faut arriver à avoir des systèmes qui gèrent mieux la propagation des fausses informations.

Le principal problème à mon sens vient que le plus souvent on ne cite pas les sources d’informations sur les réseaux sociaux. Dans Wikipédia, on demande à sourcer les informations avec des sources dites de second niveau, soit une information traitée par des journalistes le plus souvent. On insiste sur cela. Ce n’est donc pas la distinction entre sachant ou non sachant qui importe, mais la source des informations et l’habitude d’une personne à sourcer une information ou à ne pas propager des fake news. Il faut établir une forme de responsabilité et de réputation.

Concernant l’économie de l’attention, une autre solution consiste à proposer d’autres modèles économiques. Le modèle basé sur la publicité n’est pas un bon modèle et la publicité a pris une place trop importante puisqu’elle paie tout le reste. Le coût par utilisateur d’un réseau social est faible si bien que les utilisateurs pourraient accepter de payer quelques euros pour y accéder.

Les réglementations européennes (DSA et DMA) : des premières étapes pour réguler les réseaux sociaux

Serge Abiteboul : Notre ouvrage s’intitule « Nous sommes les réseaux sociaux », car nous considérons qu’il s’agit d’un problème collectif dont doit s’emparer la société. Le Digital Services Act et le Digital Markets Act ne vont pas résoudre l'ensemble des problèmes. Je les considère comme une première étape qui va dans la bonne direction tout en redoutant le trop grand centralisme de la Commission européenne. Il aurait été préférable de travailler en réseau avec des autorités de régulation nationales.

Jean Cattan : Tout d’abord, la directive dite e-Commerce adoptée en 2004 instituant une responsabilité allégée, a abouti à un système dans lequel les réseaux sociaux devenaient en quelque sorte les régulateurs de ces espaces conversationnels. Nous prônons dans notre ouvrage une régulation démocratique des réseaux sociaux, autrement dit une régulation par la société. Il faut donc définir des modes d’expériences souhaitables, viables et bénéfiques pour nous sur les réseaux sociaux. Nous défendons l'exercice d'une régulation ouverte des réseaux sociaux c'est-à-dire que le régulateur doit s'ouvrir sur la société. Alors qu’aujourd’hui ce sont les réseaux sociaux qui sont les régulateurs, demain c’est aux régulateurs de se faire réseau social, en capitalisant sur l’intelligence collective pour mieux contrôler les plateformes. Dans la tribune que nous avons publiée au Monde, nous rappelons que toute régulation devrait commencer par un accès aux données les plus pertinentes dans la mesure où les réseaux sociaux fonctionnent comme des boîtes noires. Certes, il y a des efforts de transparence qui sont faits et qui sont tout à fait louables. Mais il existe encore des choses que l'on a énormément de mal à expliquer sans avoir accès aux données des réseaux, par exemple déterminer le nombre d'utilisateurs sur telle ou telle plateforme ou le nombre de robots qui y sont présents. Il faut ouvrir ces données au monde de la recherche pour parvenir à une meilleure compréhension des réseaux sociaux. Prenons l’exemple de risque de manipulation des élections qui est identifié comme un risque systémique par le DSA. Les chercheurs auront besoin de données qui viennent des réseaux sociaux et qu’il conviendra de croiser avec d’autres informations comme les enquêtes plus sociologiques, anthropologiques ou issues des sciences humaines. Il sera alors possible d’analyser les dynamiques de partis sur les plateformes et celles qui se jouent en dehors des réseaux sociaux. À des réseaux ouverts doit répondre une régulation ouverte.

⇒ Lire aussi : S. Abiteboul et J. Cattan, « Monsieur Elon Musk, si vous voulez vraiment mettre Twitter au service de l’humanité, ouvrez-le ! », Le Monde, 8 novembre 2022.

Repenser la place de l’utilisateur sur les réseaux sociaux

Serge Abiteboul : Nous devrions nous orienter vers un monde où l’utilisateur a plus de contrôle, et où des choix lui sont proposés, des options lui permettent de plus se prendre en charge. On pourrait lui laisser le moyen de guider les choix des contenus qui lui sont proposés.

Il est difficile d’aborder la question de la modération seule : il faut nécessairement l’aborder avec la proposition des contenus en parallèle. On va peut-être arriver à une forme de proposition des contenus qui requiert un petit peu moins de fonctions de modération. On perçoit tout à fait que chaque réseau social a son ambiance, cela est lié à la communauté humaine qui vit sur ces réseaux sociaux. Toutefois, je suis convaincu que c'est aussi lié à l'architecture même des réseaux sociaux, autrement dit à la façon dont on entre sur ces réseaux sociaux, à la façon dont ils sont configurés et à la façon dont sont proposés les contenus. L’intelligence artificielle pourrait donner l'aptitude à chacun de choisir un petit peu plus son expérience.

Une des difficultés du droit au paramétrage est que les utilisateurs n'ont pas particulièrement envie et de temps à consacrer au paramétrage. Celui-ci doit au maximum être automatique, ce qui pourrait être réalisé grâce à un système de gestion des informations personnelles (PIMS). Il s’agit d’un système payé par l’utilisateur pour contrôler et protéger ses données et qui fonctionne grâce à un logiciel libre. Le PIMS est un système intelligent me permettant de gérer mes données et qui me connaît au point de pouvoir définir le paramétrage des réseaux sociaux et d’autres services numériques à ma place.

L’avenir des réseaux sociaux

Serge Abiteboul : Les mots logiciel libre et communs deviennent de plus en plus importants. Il existe et nous pouvons développer d’autres modèles qui ne sont pas basés sur la publicité. Il est en effet indispensable de permettre à d’autres réseaux sociaux d’éclore autour d'autres modèles d’affaires.

Jean Cattan : En pensant la régulation, nous pouvons préparer un terrain qui favorise la créativité et qui laisse de l’espace pour que de nouveaux réseaux sociaux ou fonctionnalités s’installent ou voient le jour. Il est important de se placer dans le temps long de la régulation évoquée précédemment. Les modalités de régulation vraiment efficaces des réseaux sociaux vont probablement se mettre en place dans les années à venir. Mais, d'ores et déjà, il est de notre responsabilité collective d'envisager quelles formes pourraient prendre ces institutions et ces modes de délibération sur le fonctionnement de nos espaces publics. D’autres initiatives vont suivre le DSA et le DMA. Pensons-y.