Reconnaissance faciale : vers une convergence transatlantique des normes techniques en matière d'équité ?

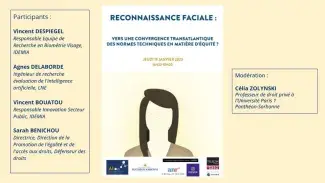

Le 19 janvier 2023 s'est tenu un webinaire portant sur " Reconnaissance faciale : vers une convergence transatlantique des normes techniques en matière d’équité ?". Ce webinaire était organisé dans le cadre du projet ANR LIMPID mené par Telecom Paris et IDEMIA en partenariat avec l'Observatoire de l'IA de l'université Paris 1 Panthéon-Sorbonne avec la participation d'Agnes Delaborde (LNE), Vincent Bouatou (IDEMIA), Sarah Benichou (DDD) et Vincent Despiegel (IDEMIA). Les débats ont été modéré par Célia Zolynski (université Paris 1 Panthéon-Sorbonne).

Cet article est un compte-rendu non-exhaustif des échanges. La captation vidéo du webinaire est également disponible.

Visionnez l'intégralité du webinaire "La reconnaissance faciale : vers une convergence transatlantique des normes techniques en matière d'équité ?"

Présentation de la conférence et des intervenants

Célia Zolynski : Ce premier webinaire est organisé dans le cadre d'un cycle de séminaires qui est porté par le projet LIMPID de l'Institut Télécom ParisTech en partenariat avec l'Observatoire de l'Intelligence artificielle de Paris 1 Panthéon-Sorbonne. Il s'agit aujourd'hui d'un premier webinaire qui va introduire une série de webinaires. Le webinaire est particulièrement consacré à “La reconnaissance faciale : Vers une convergence transatlantique des normes techniques en matière d'équité ?” Telle est la question que nous allons discuter ensemble, dans un contexte important qui est celui de l'adoption prochaine du règlement relatif à l'intelligence artificielle au sein de l'Union européenne. Dans ce contexte, il nous paraissait important de livrer un éclairage sur la démarche de normalisation actuellement à l'œuvre, particulièrement en ce qui concerne les systèmes de reconnaissance d'image et de reconnaissance faciale. L'objet des échanges est de comprendre le référentiel NIST qui va nous être présenté et de comprendre son utilisation par les acteurs du secteur ainsi que les questions qu'il pose si on le compare avec les démarches de normalisation menées au sein de l'Union européenne. S'agissant de la garantie apportée quant au respect des droits humains en ce domaine, il convient également de se demander si cette approche de normalisation peut être suffisante. Par ailleurs, elle doit être complétée par d'autres instruments afin de garantir le respect des droits humains et notamment du droit de la non-discrimination. Et pour cela, nous avons convié tout un panel d'experts de ces sujets pour nous livrer leur éclairage, mais aussi pour qu'ils puissent partager avec nous et croiser leurs analyses. Nous avons le plaisir d'accueillir quatre panélistes : Madame Sarah Benichou, Directrice au sein de la Direction de la promotion de l'égalité de l'accès des droits auprès du Défenseur des droits, Monsieur Vincent Bouatou, Responsable innovation secteur public au sein d'IDEMIA, Monsieur Vincent Despiegel, Responsable équipe de recherche en biométrie visage au sein d'IDEMIA, et enfin Madame Agnès Delaborde, ingénieure de recherche évaluation d'intelligence artificielle auprès du LNE. Pour commencer, Vincent Despiegel va nous présenter le référentiel NIST.

Le NIST et le LNE

Vincent Despiegel : Je vais définir les problèmes d'équité en reconnaissance de visage et plus particulièrement les métriques utilisées par le NIST.

Les différents types d’applications de la biométrie

La biométrie ou le visage peut être utilisé pour plusieurs types d'applications. La première application est celle des solutions d'identité. L'idée est de délivrer un droit unique à une personne : un droit de vote, un document d'identité. Lorsque l'on délivre ce nouveau document, on a besoin de vérifier que la personne n'est pas déjà dans la base de données. Pour ce faire, on va recourir à l'identification ou "du un contre N".

Par ailleurs, il y a les applications policières dont le but est la résolution de crimes. On a des images de qualité hétérogène si bien que le policier peut passer du temps sur un cas pour améliorer une image. On va vouloir, dans beaucoup de cas d'applications policières, faire du "un contre N" ou de l'identification et donc comparer l'image contre une base et essayer de rechercher cette image-là dans une base. De plus, on peut aussi évoquer les applications de contrôle aux frontières. Il s'agit d'utiliser la biométrie pour accélérer l'embarquement tout en garantissant le même niveau de sécurité. Ici, il faut comparer automatiquement la photographie de passeport avec une photographie prise de la personne et vérifier qu'il s'agit de la même identité. On fait ce qu'on appelle de l'authentification. L'idée consiste à vérifier qu'il s'agit de la même identité et dans ce cas-là d'ouvrir la porte pour permettre à la personne de passer.

On peut aussi faire de l'authentification pour des objets connectés, par exemple pour se connecter à son compte bancaire. Et pour ça, en général, on veut faire aussi de l’anti-fraude, c'est-à-dire vérifier que c'est un vrai visage et pas une photographie en face de l'écran. On a de plus des contraintes de puissance de calcul.

La reconnaissance de visage a l'avantage d'être une technologie dont la performance peut être mesurée de manière extrêmement précise. Et donc on va utiliser des métriques qu'on appelle les faux rejets et des fausses acceptances.

Le NIST (National Institute of Standards and Technology)

Le NIST est l’institut américain qui est chargé par le gouvernement américain d'évaluer un certain nombre de technologies ainsi que de déterminer ou de donner des recommandations sur les technologies qui doivent être utilisées par l'administration américaine. Depuis une vingtaine d'années, le NIST évalue régulièrement les algorithmes de reconnaissance en biométrie visage, mais aussi d'autres biométries. Ces évaluations sont faites sur des bases séquestrées, c'est-à-dire que les fournisseurs de technologie biométriques n'ont pas accès à ces bases qui correspondent à des données soit policières, soit collectées par le gouvernement américain. Le NIST garde des traces de l'évolution de performances sur trois bases de données depuis 2017.

Le faux rejet et la fausse acceptance

Un faux rejet, quand on fait de l'authentification, équivaut à considérer que deux images de la même personne appartiennent à deux identités différentes. Une fausse acceptance est le contraire : c'est-à-dire considérer à tort que deux images de deux personnes différentes sont deux images de la même personne. Pour être performant, un système doit être le plus bas possible en faux rejets et en fausse acceptance.

Ce qu'on observe, sur la période de 2017 à 2022, c'est que les performances ont grandement été améliorées et ont été même divisées par 50 en 4 ans. On est actuellement à des taux de performance en termes de faux rejets de l’ordre de 0,3 %. Autrement dit, pour une image comparée à une photographie de passeport, le système se trompe dans 0,3 % des cas et le taux de fausse acceptance est de 10 puissance moins 6, c'est-à-dire que j'ai une chance sur 1 million, si je prends le passeport de quelqu'un d'autre, d'être confondu avec cette personne.

La place de l’équité dans la biométrie

L'équité devient un sujet de plus en plus majeur pour le déploiement de la reconnaissance de visage. Il faut donc s'intéresser à la définition du fairness, la définition des métriques pour mesurer l’équité et de leurs évaluations. En termes de régulation et de standardisation, la Commission européenne a commissionné le comité ISO/SC 37 pour définir un standard pour évaluer les systèmes biométriques. Le but est de quantifier le niveau d'équité de différents algorithmes, de pouvoir les comparer et, si possible, de donner des recommandations en termes d'équité : dire quel est le niveau d'équité qui est acceptable.

L'équité peut être mesurée en identification, quand je fais du "un contre N" contre une base de données ou quand je fais de l'authentification, c'est-à-dire quand du “un contre 1” et que j'essaye de comparer une photographie de passeport avec une image. En 2019, le NIST a publié un rapport sur l'identification sur le “un contre N” et en 2022 a publié un rapport sur l'équité en “un contre un”.

Équité et performance dans la biométrie

Il faut bien distinguer l'équité et la performance. Les différences de performance sur des sous-classes sont extrêmement liées au problème d’équité. Il y a beaucoup de facteurs qui peuvent avoir un impact sur l’accuracy en reconnaissance de visages : l'ethnicité, la qualité de l'image, le genre, la pose, le fait de porter un masque, l'âge ou encore le vieillissement. D'un point de vue algorithmique, on veut être capable d'être robuste à des variations d'illumination. On veut aussi avoir de bonnes performances, même si la personne porte des lunettes ou s'il y a 20 ans d'écart entre deux images. Ces écarts de performance peuvent être vus, dans certains cas, comme des facteurs limitant des algorithmes de visage. Par exemple, il est tout à fait compréhensible que les performances de reconnaissance soient moins bonnes si la personne porte un masque que si la personne ne porte pas de masque. Par contre, il y a d'autres critères qui sont vus comme des critères discriminants. Si mes performances sont différentes entre les hommes et les femmes, c'est un problème de discrimination.

L'équité consiste donc à mesurer les différences de performance entre différents facteurs démographiques, donc sur différentes classes d'âge, sur les hommes et sur les femmes, et en fonction de différents critères d'ethnicité. L'équité se soucie des différences d’accuracy entre les différents groupes. Les critères démographiques peuvent être continus. L'évaluation de ces différences de performance se réalise sur des différences au sein de ces sous-catégories. En ce qui concerne l'ethnicité en général, on n'a pas de label disponible, à l'exception d'auto-déclaration pour les États-Unis. Toutefois, on peut utiliser des proxys pour l'évaluation des biais en ethnicité par exemple. Si on observe des différences de performances en fonction des régions d'origine, on aura des différences de performances sur d'autres sous-catégories qu'on ne peut pas définir. Ensuite, on va vouloir mesurer les écarts entre les erreurs que l'on fait suivant les sous-catégories. Ces erreurs n'ont pas forcément le même impact d'un point de vue sociétal. Prenons deux exemples qui sont l'authentification et l'identification. Si je fais une authentification contre une photographie de passeport, si le système se trompe et rejette à tort quelqu'un alors que c'est bien son passeport, la porte ne va pas s'ouvrir et on va obliger la personne à aller voir un douanier. Si les performances sont différentes en fonction des sous groupes, il s'agit d'un problème de discrimination puisqu’on va rejeter plus souvent un sous-groupe par rapport à un autre. Par contre, si je fais des fausses acceptances, si je ne suis pas équitable en termes de fausses acceptances, lorsque quelqu'un arrive avec un passeport qui n'est pas le sien, je vais l'accepter à tort, plus souvent pour une catégorie que pour une autre. Dès lors, cela devient un problème de sécurité et cela ne sera pas perçu comme un problème de discrimination. En un contre N, les faux positifs consistent à me confondre à tort avec une personne dans une base de données alors que ce n'était pas moi. De la même manière, ces erreurs vont conduire à des investigations incorrectes et posent un problème d’équité si ces taux sont variables en fonction des sous-catégorie.

Une manière d'évaluer si un algorithme est équitable ou non consiste à regarder la distribution des scores pour les faux négatifs et pour les faux positifs entre différentes sous-classes. C'est exactement ce qu'a fait le NIST en analysant les différentes distributions entre les hommes, entre les noirs et les blancs. Le NIST a observé qu'il y a une superposition parfaite des deux histogrammes. Et comme il y a une superposition parfaite des deux histogrammes, cela implique que le taux de faux positifs à un seuil donné en identification de visage est le même. Par conséquent, il n'y a pas de discrimination. C'est ce qu'a noté le NIST dans son rapport en indiquant que certains développeurs avaient fourni des algorithmes d'identification pour lesquels la différence de faux positifs était indétectable, quelle que soit la catégorie sous-catégorie en “un contre un”.

Le choix de la métrique

Il y a un certain nombre de discussions sur la bonne métrique à utiliser en fairness, que ce soit au sein des comités ISO, mais aussi avec le NIST. Le NIST a fait appel à contribution pour fournir des métriques. On en a proposé certaines. D'autres fournisseurs en ont proposé d'autres. Il faut maintenant réussir à avoir une métrique qui satisfait deux exigences qui peuvent être parfois un peu antagonistes. La première exigence est que l'on veut que la métrique soit le plus explicable possible, c'est-à-dire qu'on va être capable de l'interpréter. Une fois qu'elle est relativement facile à interpréter, on veut qu'elle soit relativement stable, même si je me retrouve à séparer la population en plus de sous-catégories. Si par exemple je veux regarder l'équité sur les fausses acceptances, je vais regarder la classe sur lequel j'ai le maximum de fausses acceptances divisé par la classe sur lequel j'ai le moins de fausses acceptances. Ce ratio montrera l'écart qui existe entre la classe sur laquelle il y a le plus d'erreurs et la classe sur laquelle il y a le moins d'erreurs. Si l’algorithme est parfait et parfaitement “fair”, mon niveau de fairness va être de un, c'est-à-dire que mon max va être égal à mon min. Plus mon max sur mon min va être important, plus mon algorithme va être inéquitable. Cette métrique a un problème en cas de séparation en beaucoup de sous-catégories car il y aura une forte probabilité d'obtenir une sous-catégorie sans aucune erreur. Et donc cette métrique-là, elle va exploser, elle ne va plus avoir aucun sens. Une manière de lutter contre ce problème s'avère de changer le dénominateur par une moyenne plutôt que par le min. Il est préférable d'utiliser la moyenne géométrique plutôt que la moyenne arithmétique. Cette définition de fairness a l'avantage d'être un peu plus stable tout en étant assez facilement interprétable puisque c'est le max sur la moyenne.

Une autre métrique de fairness qu'on pourrait avoir envie d'utiliser, c'est le coefficient de Gini. Celui-ci est utilisé en économie pour mesurer le niveau d'inégalités de salaires, par exemple au sein d'une population. Il a l'avantage d'être assez stable même si j’augmente le nombre de sous-catégories. Il présente l'inconvénient d'être peut-être plus difficile à interpréter.

Précédemment, on a expliqué, pour des raisons de stabilité, pourquoi on pouvait préférer des métriques qui ne sont pas le max sur le min, mais plutôt max sur la moyenne ou le coefficient de Gini. Et on a donc ici le max sur la moyenne géométrique et le coefficient de Gini. On observe que les deux algorithmes, présentant un très bon niveau d’accuracy, obtiennent des performances en termes de max sur moyenne géométrique ou de coefficient de Gini, qui sont extrêmement mauvais. On a aussi des algorithmes avec un très bon niveau de fairness mais des performances biométriques mauvaises. Ce n’est pas forcément difficile d’avoir un algorithme parfaitement équitable mais présentant de très mauvaises performances biométriques. En effet, un algorithme aléatoire est parfaitement équitable. L'algorithme proposé par IDEMIA présente un bon compromis performance/équité. Ainsi, il est faisable d'avoir un bon compromis en termes d'équité et de performance globale.

On pourrait croire que le seul moyen ou le meilleur moyen d'avoir un algorithme équitable est d'avoir une base qui est la plus équilibrée possible. En vrai, ce n'est pas le cas. Ce n'est pas suffisant et ce n'est même pas forcément nécessaire. On a fait des expériences avec plusieurs proportions d'hommes et de femmes dans nos bases d'apprentissage. On observe que plus on augmente la proportion de femmes dans la base d'apprentissage, plus on améliore les performances sur les femmes. Par contre, ce qu'on observe, c'est que si j'ai 50 % d'hommes, 50 % de femmes, le niveau de performance en reconnaissance entre les hommes et les femmes n'est pas équivalent. Ce qui signifie qu'une base équilibrée ne permet pas de garantir qu'on va avoir une base de performance égale entre les différentes sous-catégories. Un moyen d’y remédier est de travailler sur les fonctions de coûts. On peut contrôler le niveau de densité locale en termes d'ethnicité, de genre et d'âge, pour faire en sorte d'équilibrer artificiellement notre sphère et faire en sorte que nos points soient le plus équitablement répartis et occupent autant de place pour toutes les sous-catégories.

Pour conclure, que peut-on retenir de cette présentation ? Premièrement, l'état de l'art scientifique est suffisamment mûr pour permettre de gérer plusieurs critères (fairness et performance). Cela étant dit, l'écosystème est en train de mûrir pour définir des seuils, des métriques et les compromis qu'il faut utiliser. Des règles et des standards sont en cours de développement et il s'agit de quelque chose de vraiment important à garder en tête. Concernant l'évaluation de l'équité, l'équité ne peut absolument pas être inférée du code source ou de l'analyse la plus fine possible des bases d'apprentissage. Un moyen de mesurer et d'évaluer la fairness est d'avoir des bases représentatives, bien choisies, si possible séquestrées pour éviter d'avoir du sur-apprentissage, et de mesurer l'équité directement avec les bonnes métriques.

Célia Zolynski : Cette présentation va nous permettre d'introduire des discussions et notamment de comprendre des rapprochements avec la démarche de normalisation qui s'opère au sein de l'Union européenne. Et à cet égard, compte tenu de ses fonctions, on va se tourner vers Agnès Delaborde. Vous êtes ingénieur de recherche évaluation d'intelligence artificielle au sein du LNE. Pourriez-vous nous expliquer justement cette démarche de normalisation à laquelle vous contribuez au sein de l'Union européenne? Et particulièrement, quel est le rôle du LNE en ce domaine? Qu'y a-t-il d'essentiel dans la perspective de l'adoption prochaine du règlement AI Act, notamment pour garantir l'équité en matière de reconnaissance faciale ? Existe-t-il des points de convergence avec les normes qui se construisent à l'international et notamment le référentiel NIST que vient de nous présenter Vincent Despiegel ? Comment être sûr que les systèmes de reconnaissance faciale soient respectueux des droits fondamentaux ? Des certifications sont-elles envisagées s'agissant de la garantie du respect de ces droits?

Le LNE (Laboratoire national de métrologie et d’essais) et l’IA

Agnès Delaborde : Le LNE dont je fais partie est le Laboratoire national de métrologie et d'essais. Nous sommes un laboratoire public français. Nous sommes sous la tutelle du Ministère de l'Industrie et nous avons des fonctions qui sont assez similaires au NIST. Pour notre part, nous sommes chargés à l'échelle de nous assurer de la conformité des produits qui sont mis sur le marché en France. Pour ce faire, nous avons différentes branches d'activité : l'évaluation, la certification et également la métrologie. Dans mon département, nous sommes spécialisés dans les produits à base d'intelligence artificielle.

Concernant les actions au niveau européen à l'heure actuelle en normalisation, la Commission européenne a publié en avril 2021 une proposition de règlement pour les systèmes d'intelligence artificielle. Nous sommes donc toujours dans la phase de discussion entre les États membres, le Parlement et le Conseil. Or, ce que l'on sait, c'est qu'à l'horizon 2025, en Europe, tous les systèmes d'IA seront soumis à cette réglementation européenne qui met en exergue très fortement les systèmes d'IA dits à haut risque et qui se focalise fortement sur les systèmes de biométrie. Évidemment, comme il va y avoir un règlement et donc une loi qui va s'appliquer pour les industriels, ces derniers et les organismes de surveillance vont avoir besoin de s'appuyer sur des normes qui vont leur donner des spécifications, des recommandations, des exigences. Donc, en parallèle de tous ces développements de la réglementation européenne, le CEN-CENELEC (Comité Européen de Normalisation Électronique et Électrotechnique), qui est l'un des organismes de normalisation au niveau européen, a été mandaté afin de créer des normes en vue d'assurer une présomption de conformité à l'AI Act. Donc, nous avançons en parallèle de la finalisation de l'AI Act et nous essayons de déterminer les obstacles et les enjeux. Par exemple, nous devons nous assurer que ce qu'on va définir dans les normes ne va pas bloquer le marché international. Par exemple, si on a une définition de l'équité, celle-ci ne doit pas être fondamentalement différente de ce qui sera fait, par exemple du côté des États-Unis ou même du côté de ce qui est fait dans les normes internationales, les normes ISO. Nous avons un autre enjeu : les normes que l’on doit créer doivent être « transverses », c’est-à-dire qu’elles concernent tout système d’IA, indépendamment de son contexte d’application. Charge à chaque secteur d’activité de se doter des normes spécifiques à leurs métiers.

La principale mission du NISTR : l’évaluation

Vincent Bouatou : En complément, ce que fait le NIST est de l'évaluation. Ce n'est pas en effet une activité de vérification de conformité. Il s’agit de connaître la performance d'un produit. On ne va pas forcément établir qu'il est conforme ou qu'il n'est pas conforme à tel ou tel standard. Il apparaît, de manière assez évidente, que la simple évaluation des performances ne peut pas suffire en tout cas à un utilisateur final. Il convient donc de déterminer si tel ou tel produit est conforme à telle ou telle réglementation. En tant que développeur de solutions, il nous semble que la conformité notamment prévue dans le règlement européen sur l'intelligence artificielle nécessitera la combinaison de normes techniques. Des normes organisationnelles vont peut être potentiellement s'appliquer, ou en tout cas être davantage applicables à certaines parties prenantes et moins à d'autres. De la même façon, un écosystème de certification sera plus applicable à un tel système.

En ce qui concerne les normes techniques et organisationnelles, nous faisons de l'anticipation puisque le règlement européen sur l'intelligence artificielle n'est pas encore adopté. Cela veut dire que nous développons des produits et des technologies qui sont conformes à l'esprit de ce qui se dégage dans le règlement sur l'intelligence artificielle, mais aussi qui mettent en œuvre des moyens de contrôle et de gouvernance qui permettront à nos clients de mettre en œuvre des normes organisationnelles. Il est difficile de demander à des industriels qui fournissent des solutions d'être conformes à des normes organisationnelles dans la mesure où ils ne seront pas en charge des opérations de ces systèmes et services. Nous tâchons de préparer nos produits de façon à faire en sorte qu'ils facilitent la vie des utilisateurs dans le respect de ces normes organisationnelles. On peut parler de gouvernance de données, de transparence ou encore de capacité d'audit. Dans la plupart des cas, l'intelligence artificielle n'est pas un moteur de décision, mais le moteur d'aide à la décision va mettre en œuvre des dispositifs dans les produits qui vont permettre à nos utilisateurs de se rendre conformes. La démonstration de cette conformité sera probablement lourde chez nos clients, notamment nos clients du secteur public.

L'évaluation seule ne peut pas suffire à évaluer la conformité, à déterminer la conformité d'un produit à un règlement. Pour autant, en matière d'intelligence artificielle, notre compréhension de l'état de l'art est qu'une norme qui précisera la façon dont sont organisés le développement et les techniques scientifiques à utiliser dans le cadre de déploiement d'algorithmes aurait deux effets délétères. Premièrement, elle briderait l'innovation alors que l'intelligence artificielle est un domaine qui évolue extrêmement vite. Deuxièmement, donner un certain nombre de bonnes pratiques à un développeur pour l'obliger à suivre des bonnes pratiques de développement ne suffira pas à garantir que le produit de ce développement sera conforme à une éventuelle norme.

L'exemple typique est celui de la proposition de règlement européen qui dispose que les bases d'apprentissage doivent être équilibrées afin de garantir l'absence de biais des algorithmes. Or, le seul équilibre des bases de données ne permet pas d'obtenir d'arriver à ce résultat. Il faut être très attentif à la façon dont on fait ces apprentissages. L'équilibrage n'est peut être pas nécessaire, voire contreproductif. C'est pourquoi il convient de vérifier, de tester, d'évaluer le produit final dans un environnement proche de celui de son utilisation.

Troisièmement, il y a un besoin de convergence qui va être fort. Deux points sont à mentionner sur ce point de convergence, le premier est que le NIST ne prend pas position quant à la valeur absolue de telle ou telle métrique par rapport à une métrique qui serait une métrique seuil. Aujourd'hui, le NIST se garde bien de prendre cette décision là, y compris pour le marché américain. Le NIST a été mandaté par le gouvernement américain en 2001 pour procéder à l'évaluation de toutes les technologies qui peuvent concourir à la sécurité nationale américaine. La façon dont le NIST teste ces technologies, bien évidemment, correspond à ce mandat. Il teste donc ces technologies avec des cas d'usage qui sont importants pour le gouvernement américain, pour sa sécurité nationale, avec des jeux de données qui sont représentatifs de ces cas d'usage. Peut-on transposer la méthodologie ? Sans aucun doute. Cependant, aux États-Unis, puisqu’encore une fois, ils suivent une méthodologie qui est définie par des standards internationaux. Cela étant, transposer directement les résultats peut être un peu hasardeux. Donc la convergence doit aussi se faire pour vérifier que la façon dont cette évaluation est faite est pertinente par rapport aux cas d'usage pour lesquels on souhaite établir des conformités au niveau de l'Union européenne.

La question de la mise en place de la normalisation pour les systèmes d’IA

Agnès Delaborde : Monsieur Bouatou, je vous rejoins totalement sur les préoccupations que vous évoquez, sur ce que doivent être les normes, ce qu'elles doivent concerner. Des normes techniques qui concernent les produits vont concerner également les aspects organisationnels. Je confirme que les normes harmonisées de la requête de normalisation de la part de la Commission européenne couvrent bien ces aspects. Personne ne prendra le risque de donner des spécifications qui seraient trop précises sur un système d'IA dans une tâche d'application particulière. Cela irait en effet à l'encontre de notre ambition d'être horizontaux. De plus, cela bride totalement l'innovation. Après, on se pose la question du niveau d'abstraction auquel on doit s'arrêter. Qu'est-ce qui va concerner toutes les IA? Y a-t-il des articulations avec les verticales métiers ou les cas d'applications telles que la biométrie? Nous allons probablement tester nos normes en interne sur des cas d'usage.

Vous avez également évoqué le fait que les aspects organisationnels pourraient être lourds à mettre en place, ce que j'atteste. En effet, on a pu constater, parmi les organismes qu’on a certifiés, dans le cadre de notre certification de processus IA et ceux qui ont prétendu à la certification que cela implique une restructuration structurelle qui n'est pas négligeable dans certains cas. Pour un grand groupe, cela peut être relativement facile, voire ils y ont déjà pensé depuis très longtemps. Pour de plus petites entreprises, cela peut imposer des exigences notamment en termes de documentation, pour lesquelles ils peuvent avoir un peu plus de mal. Cela est pris en compte par la réglementation. Je considère que l'on peut garantir assez bien à la fois l’accuracy et la notion de fairness. Dans les études qu'on a menées, on s'est rendu compte qu'il y avait une grosse contradiction entre ces différents attributs de qualité des bases de données. Une base de données pourra difficilement être représentative et diverse à la fois, parce qu'il y a une opposition. Il y a une contradiction, rien qu’au sein de la définition.

Célia Zolynski : Je souhaite mêler à la discussion le propos du Défenseur des droits à travers sa représentante, Sarah Benichou. Vous avez mené, au sein du Défenseur des droits, d'importants travaux s'agissant des biais algorithmiques en association avec la CNIL ainsi qu'un rapport sur les technologies biométriques. Auriez-vous des remarques s'agissant de ces garanties qui vous semblent suffisantes quant au processus de normalisation ? Au regard notamment du droit de la non-discrimination, identifiez-vous des ajustements nécessaires ou peut être même une contrariété intrinsèque ? Quel est le regard, du moins votre regard, ou peut être celui de votre institution, même si on sait que les éléments sont en cours de discussion ?

Les droits humains et la reconnaissance faciale

Sarah Benichou : À titre liminaire, il faut souligner les différences à la fois démographiques et juridiques entre les États-Unis et la France, puisqu'il s'agit de reconnaissance faciale.

Le RGPD au niveau européen et les points de divergence en matière de réglementation entre les États-Unis et la France

Au niveau juridique, en matière de protection des données personnelles, et en particulier concernant les des données considérées comme « sensibles » que sont les données biométriques qui sont traitées dans la reconnaissance faciale, il existe de grandes différences sur l'encadrement, par exemple à travers la loi Informatique et libertés en France ou le RGPD au niveau européen. Par ailleurs, le droit à la non-discrimination qui existe également aux États-Unis diffère. Parmi les missions du Défenseur des droits figurent celle de la protection contre les discriminations et de la promotion de l'égalité. Et c'est notamment à ce titre qu'on s'est intéressé au sujet des biais et des algorithmes avec la publication des travaux co-réalisés avec la CNIL en 2020 et alertant sur ces biais dans les algorithmes et sur le risque de discrimination et d'amplification des discriminations qu'on constate déjà au niveau des humains que nous sommes et des discriminations. Celles-ci sont donc produites notamment par les humains et sont ensuite évidemment traduites dans les données sur lesquelles sont amenés à travailler les algorithmes. De manière générale, et c'est à l'aune de ce mandat qu'on a travaillé le sujet. On avait l'année suivante approfondi le sujet sur les enjeux de biométrie, donc de reconnaissance faciale notamment.

Nous nous appuyons bien sûr sur les textes d'abord existants et le RGPD peut être une source très intéressante, y compris pour nos homologues organismes de lutte contre les discriminations en Europe. En effet, à travers les exigences de transparence et d’explicabilité, on peut déjà obtenir certaines informations qui peuvent aider à étudier les aspects de discrimination. Certains traitements ne franchissent pas cette étape-là d'un point de vue légal et ça permet d'obtenir éventuellement le retrait, l'annulation ou des condamnations, parfois de haut niveau, de la part de la justice. Le RGPD et le cadre juridique applicable au traitement des données personnelles est donc un appui.

Le droit de la discrimination et les prises de décision via les algorithmes

Il est utile de faire un rappel plus précis cette fois-ci sur le droit de la discrimination qui évidemment s'applique également aux décisions qui sont notamment issues des algorithmes. J'en profite d'ailleurs pour faire un petit pas de côté à ce moment-là par rapport à des propos qui ont été tenus en France, en l'occurrence en matière de décisions administratives : le principe est qu’il ne peut pas y avoir, sauf exceptions, de décisions complètement automatisées. Et donc il est de façon générale et en dehors des exceptions prévues censé y avoir une intervention humaine qui décide finalement d'aller ou non dans le sens proposé par l'algorithme et donc de décider de “quelque chose”. Ce “quelque chose” devient opposable à la personne et peut éventuellement être contesté devant le Défenseur des droits par exemple. En l'occurrence, on constate que les algorithmes sont notamment mis en place pour gérer des masses de données ou des masses de demandes. Ils sont aussi mis en place parfois pour supprimer du personnel et alléger la charge de ces personnels-là. Par conséquent, l'intervention humaine est souvent très limitée parce que la personne en charge ne va pas forcément être à la barre, et avoir les moyens de reprendre l'ensemble des dossiers traités par l'algorithme pour vérifier éventuellement les problèmes que cela pourrait poser. On voit cela sur des algorithmes extrêmement simples, non pas du tout des algorithmes d'apprentissage, tels que Parcoursup où on peut penser que les universités n'ont pas les moyens de vérifier chacune des décisions de rejet qui ont été réalisées.

Les critères et les différents types de discriminations

Le droit de la non-discrimination est largement un droit européen. En matière de droit de la non-discrimination, on a un certain nombre de directives européennes qui s'appliquent totalement en droit français, mais aussi dans chacun des États membres, notamment sur les questions de discriminations fondées sur le sexe ou fondées sur l'origine. En matière d'emploi, on a une directive transversale aux différents critères de discrimination qui sont prévus en droit européen. En Europe, il y a six critères de discrimination qui sont prévus : la nationalité (avec la règle de liberté de circulation des travailleurs européens), tout ce qui tourne autour de l'origine (qu'il s'agisse de couleur de peau, de l’origine ethnique ou géographique), l'orientation sexuelle, le handicap (auquel on peut souvent adjoindre l’état de santé, notamment quand il est handicapant), l’âge et enfin, la religion. Ce sont les grands critères qui sont protégés par le droit européen.

La non-discrimination interdit de faire des différences de traitement sur la base de ces critères puisque quand on agit ainsi, on est en train de commettre “une discrimination” qu'on qualifiera de “directe” en droit européen et en droit français également (puisqu'on a transposé toutes ces définitions en droit français, notamment dans une loi du 27 mai 2008).

Une deuxième définition qui nous intéresse, notamment en matière d'algorithmes, c'est “la discrimination indirecte”. Dans ce cas, il n’y a pas un critère de discrimination qui, par exemple, serait intégré en tant que tel dans l'algorithme pour aboutir à la décision. Mais il peut y avoir une pratique ou un critère neutre en apparence, et dans les résultats produits par l’algorithme en cause, on constaterait a posteriori le traitement défavorable d’un groupe de personnes pouvant se rattacher à un critère prohibé. Cela pose la question de pouvoir accéder au fonctionnement de l’algorithme de façon globale, et pas simplement pour un individu – car cette approche individuelle ne permet pas forcément de saisir la discrimination indirecte. Et c'est parfois difficile de le savoir pour des raisons parfois juste juridiques. Prenons un exemple : on oppose le droit à la propriété intellectuelle parfois pour des raisons techniques. Donc un algorithme pourrait être considéré comme une pratique neutre en apparence, ou le critère dont il se sert pourrait lui aussi être neutre en apparence, c'est-à-dire ne constituant pas un critère de discrimination au sens du droit européen (sachant, soit dit en passant, que le droit français contient beaucoup plus de critères de discrimination), mais entrainant néanmoins un désavantage particulier, pour une population protégée par le droit, à une discrimination telles que les personnes en situation de handicap ou les minorités.

En Italie, il y a eu une décision de justice sur des livreurs Deliveroo (Tribunal de Bologne, 31 décembre 2020). Les livreurs ont mis en cause la licéité de l'algorithme qui gérait dans leur travail l’attribution des créneaux sur lesquels ils pouvaient travailler. Et il y a évidemment des créneaux qui sont plus intéressants que d'autres : ceux qui correspondent aux horaires du déjeuner et du dîner sont beaucoup plus intéressants financièrement. L'algorithme va proposer les meilleurs créneaux à ceux qu'il estime être les meilleurs livreurs, et notamment avec une évaluation. Celle-ci tient compte du fait que, par exemple, les livreurs aient pu avoir des absences inopinées. Et cela a été contesté. La prise en compte de ce critère, neutre en apparence, ne correspond pas à un critère de discrimination très explicitement. La cour a d’abord regardé les questions d’explicabilité, de transparence et d'équité, mais elle s'est aussi intéressée à ce critère des absences inopinées. Elle a considéré qu'il y avait discrimination parce que ce critère neutre en apparence venait en fait évidemment particulièrement désavantager les personnes malades. En droit de la non-discrimination, il y a le critère de l'état de santé puisque si on n’est pas un malade chronique, on voit bien comment on peut, du jour au lendemain, avoir un problème de santé qui fait qu'on ne va pas pouvoir travailler, état de fait qui sera traité par l’algorithme comme une absence comme les autres. Et la cour a également estimé que ce critère, neutre en apparence, était problématique au regard du droit de grève qui lui aussi est protégé en la matière. Le système a donc été considéré comme discriminatoire et illégal. Il a depuis été modifié. On a une saisine en cours au Défenseur des droits un peu autour de ces mêmes questions.

La notion d’équité

On va lier au recueil et au traitement des données et au droit à la vie privée qui nous permet déjà d'avoir des informations qui, peut-être, vont nous permettre éventuellement d'envisager ou de nous dire qu’il y a un problème de discrimination derrière.

Il est question d'équité de manière importante dans le RGPD qui s'applique. Il existe un certain nombre d’exigences qui sont fixées. La loi française est d'ailleurs un peu plus exigeante pour les algorithmes utilisés dans la décision administrative. Mais on a également une disposition dans le RGPD qui prévoit déjà, dans l'article 35-2, d'avoir des analyses d'impact, notamment pour déterminer si on a des risques élevés pour les droits et libertés des personnes physiques. Le thème est même très large et aujourd'hui, dans les analyses d'impact qui sont réalisées, on a davantage des analyses d'impact sur des droits qui sont directement prévus dans le RGPD. Ce dernier ne fait pas mention explicitement au droit à la non-discrimination. S’agissant du lien entre l’évaluation du risque de discrimination et les analyses d’impact relatives à la protection des données (AIPD) telles que prévues à l’article 35 du RGPD, les lignes directrices concernant l’AIPD adoptées par le G29 (CNIL européennes) en 2017 font état de ce que le « risque élevé pour les droits et libertés des personnes physiques » mentionné à l’article précité vise notamment « l’interdiction de toute discrimination » (p 7 des LD). En outre, le fait que le traitement puisse entrainer « l’exclusion ou une discrimination » sert à illustrer une prise de décision automatisée avec effet juridique ou effet similaire significatif, qui constitue l’un des cas où l’AIPD est requise.

Concernant la réglementation à venir, le Défenseur des droits a, en juin dernier, produit un avis sur le projet de règlement européen sur l’intelligence artificielle (AI Act) avec EQUINET, qui est le réseau des organismes de lutte contre les discriminations en Europe, sachant que ces organismes ont été prévus notamment par les directives de non-discrimination. Cet avis alerte sur le fait que les questions de discrimination devraient apparaitre de manière plus centrale dans le projet, avec des problématiques aussi liées à la question de la classification, dans le projet, des « systèmes d’IA à haut risque ». On indique évidemment que tout dépend bien sûr des domaines d'application, mais également des problématiques de discriminations. On peut avoir un algorithme qui n'est pas considéré à risque parce qu'on est dans un domaine qui n'est pas considéré comme vraiment problématique, notamment car il existe des alternatives. Ce qui n'est pas le cas évidemment, en matière de service public : on est souvent obligé d'être soumis à un algorithme qui a été proposé. Et pour autant, cet algorithme peut se révéler extrêmement biaisé et ainsi discriminatoire, avec des refus d'entrée à des endroits, des problématiques de non-accès et de non-recrutement, etc. C’est un problème pour nous et on espère que le projet de règlement va exiger des analyses d'impact, y compris en matière d'équité ou en tout cas va être un peu plus clair sur ces éléments-là, parce qu'ils sont évidemment problématiques. On voit que s'agissant des algorithmes de reconnaissance faciale, il y a eu une amélioration de la performance et de l'équité. On ignore en France tous les algorithmes de reconnaissance faciale qui sont utilisés. Parce que s’il y a un taux d'erreur important sur certaines populations, il pourrait y avoir des conséquences telles que des entraves à la liberté de circulation, des contrôles et des arrestations. On sait que c'est arrivé aux États-Unis de manière très claire.

Les réactions entre panélistes

Célia Zolynski : Peut-on envisager une convergence entre normalisation, démarche de normalisation et respect des droits humains ? Quelle est finalement la question qui peut se poser ? Une question a été posée par le public s'agissant de la possibilité de créer une base d'images de tests en Europe dans l'Union européenne, compte tenu des exigences du RGPD. Auriez-vous quelques éléments à nous livrer sur ce point, compte tenu notamment du cadre de traitement des données sensibles ? Pourrait-on souhaiter un aménagement de celui-ci pour arriver à la constitution de telle base ?

Sarah Benichou : Nous avons des discussions, notamment avec la CNIL ou avec d’autres acteurs sur ces enjeux sur le fait que le cadre juridique soit largement européen. À l'heure actuelle, il y a une interdiction de principe de recueil et de traitement des données sensibles, sachant que ces données sensibles, qui sont listées dans la loi, ne recoupent pas exactement les critères de discrimination. Par exemple, le sexe n'est pas une donnée sensible alors qu’il s’agit évidemment d’un critère de discrimination. En revanche, sur d'autres critères, on a un recoupement. C'est le cas sur l'origine ou encore sur l'état de santé.

On a ce principe d'interdiction de traitement. Il existe néanmoins beaucoup d'exceptions qui sont prévues à ce principe. Par exemple, avec l’enquête Trajectoires et origines, les premiers résultats montrent que pour les personnes résidant en France, si l'on prend les plus de 60 ans déjà pour toutes les personnes résidant en France, on est approximativement à 30 % d'immigrés, de descendants d'immigrés. Si on regarde les âges au-dessus de 60 ans, on a dans ces populations donc descendants, immigrés et descendants d'immigrés, une majorité de personnes d'Europe du Sud. Si on regarde les jeunes, on a une majorité de personnes d'origine subsaharienne, donc on constate que ce ne sont pas les mêmes profils, y compris derrière en reconnaissance faciale et en alimentation de banques de données. Les dispositions françaises interdisent de mettre en place un référentiel ethno-racial. Il faudra regarder comment on peut bâtir ces données. À mon sens, il me semble important qu'on puisse avoir ces données non seulement pour entraîner, mais derrière, pour tester aussi un certain nombre de ces algorithmes.

Vincent Bouatou : Si je peux me permettre un commentaire sur ce qui a été repris à la fois par madame Bénichou et madame Delaborde. Concernant les équilibres entre performance et équité dans les algorithmes, je trouve qu'il y a énormément de progrès qui ont été faits en matière d'essais. Madame Delaborde a tout à fait raison lorsqu'elle explique qu'il y a une forme de déséquilibre entre la performance et l'équité et que l'algorithme le plus performant n'est pas forcément l'algorithme le plus équitable. La performance est une chose à définir en fonction d'un cas d'usage, de l'objectif poursuivi, etc. Prenons un exemple un peu caricatural, mais il est révélateur des questions que doivent se poser les développeurs de ces algorithmes, lorsqu'ils sont face à des choix techniques. Supposons que nous ayons un algorithme de prédiction de diagnostic médical qui est capable, sur la base d'un certain nombre d'éléments, de prédire si oui ou non vous avez telle ou telle maladie. Il n'est pas parfait, il fait des erreurs, donc il peut à la fois vous dire que vous êtes malade lorsque vous n'êtes pas ou dire que vous n'êtes pas malade alors que vous l'êtes. Supposons deux algorithmes : un qui, sur une population A, obtient une précision de 99 % et sur une population B une précision de 95 %. Il y a donc un biais, une vraie différence. Supposons qu'un autre algorithme obtienne une performance de 80 % sur les deux populations. L'algorithme le plus équitable, me semble-t-il, est le deuxième, celui qui a exactement les mêmes performances sur la population A et la population B. Pour autant, si on regarde le bénéfice qu'en retire chacune des populations de l'application de cet algorithme, la réponse est que le premier algorithme apporte plus de bénéfices, même s'il est biaisé sur les définitions. Prendre classiquement des performances et des biais s'avère donc très difficile pour un développeur. Il doit prendre ses décisions sans le moindre guide vis-à-vis du cas d'usage et du respect des droits fondamentaux. Et je crois que cet exemple se transcrit de manière très concrète dans des choix techniques que doivent faire des ingénieurs développant des systèmes d'intelligence artificielle. Ils sont peu aidés dans cette prise de décision.

Célia Zolynski : Madame Delaborde, auriez-vous des précisions à apporter, notamment à la veille de l'adoption du règlement dit AI Act.

Agnès Delaborde : Je pense que nous n'avons pas forcément mis en avant le lien entre la notion d'équité et de fairness et la différence entre la légalisation et les normes. Les textes juridiques s'appuient sur les droits fondamentaux, les valeurs de l'Union européenne qui incluent des notions d'équité, de non-discrimination. Il s’agit de la motivation initiale clairement expliquée dans les considérants en préambule de l'AI Act. Si on regarde autour de la communauté de l’intelligence artificielle, il y a eu aussi beaucoup de travaux mandatés par la Commission européenne pour essayer de défricher cette notion d'éthique au sens très large de ce qu'était le respect des individus. L'ambition était une déclinaison en termes d'exigences très techniques, précises. On comprend que l'ambition plus large était de s'assurer de l'équité. Il faut être conscient de l’importance de la notion de confiance. Dans le préambule de l’AI Act, cette notion est omniprésente, et un grand nombre d’acteurs, qu’ils soient privés ou publics, s’emparent de cette notion et veulent produire de la confiance, garantir une IA de confiance.Toutefois, les dispositions du règlement en lui-même ne reprennent plus cette notion de confiance, et il n’est donc pas forcément facile de dire ce qu’est précisément la confiance au regard de l’AI Act. Est-ce que répondre à toutes les exigences de l'AI Act permettra de garantir cette confiance ? Je reviens sur la notion de confiance qui inclut selon nous côté normatif, cette notion de fairness et également de performance, de robustesse. En normalisation, on essaye de relier les notions et de comprendre en quoi consiste le lien de confiance.

Les questions du public

Célia Zolynski : Je me permets de relayer les questions du public. On nous interroge sur des précisions pour savoir pourquoi, sur une base de données équilibrée par exemple 50 % de femmes, 50 % d’hommes, les résultats de l'algorithme de reconnaissance faciale pourraient être biaisés en faveur des hommes ?

Vincent Bouatou : Sur ce cas précis, la communauté scientifique n'a pas d'explications précises. Cependant, il s’agit d’un constat qui est observé pour la majorité des fournisseurs. On a une différence de performances entre les reconnaissances sur les hommes et les reconnaissances sur les femmes, même si les bases sont biaisées. Ce sont des tests que nous, on a fait en interne, mais aussi des tests qui ont été faits de manière extensive par la communauté scientifique et qui observent le même type de conclusion. Je vais prendre un autre exemple sur lequel ce sera plus évident qu'il peut y avoir des différences. En fait, on peut avoir des différences de performances sur une base équilibrée quand les tâches n'ont pas le même niveau de difficulté. Prenons l’exemple dans lequel on veut faire de la reconnaissance biométrique, quel que soit l'âge. On peut être capable de reconnaître des enfants et on veut aussi être capable de reconnaître des personnes qui ont 70 ou 80 ans. Les performances biométriques, malgré le fait que la base d'apprentissage soit équilibrée, seront meilleures sur les personnes âgées que sur les enfants, de manière un peu similaire que les performances de reconnaissance. Le fait de compenser ou d'équilibrer la base pour avoir les meilleures performances ne suffit pas à compenser ces difficultés. On peut faire le choix de surreprésenter une population sur lequel on a de moins bonnes performances. On peut aussi modifier l'algorithme et la manière avec laquelle on optimise l'algorithme pour faire en sorte de donner plus de poids à ces catégories. Quoiqu'il en soit, la surreprésentation pose des problèmes pour d'autres éléments. La qualité de la base de données est essentiel à un compromis expert qui doit être obtenu. Si on améliore la représentativité, on va détruire un autre élément qui peut être essentiel.

Célia Zolynski : Il y avait une autre question, s'agissant cette fois-ci d'un algorithme de diagnostic médical. Si un algorithme de diagnostic médical est plus efficace pour une population et qu'il s'avère que la pathologie détectée a un caractère génétique, peut-on prétendre que l'algorithme discrimine ? Ces essais nous posent la question précise de la causalité : peuvent-ils in fine se traduire par un biais dans la précision du diagnostic, du simple fait qu'il n'est pas possible de prévoir comment la base de données d'entraînement devrait être constituée ?

Vincent Bouatou : Si la question m'est adressée, je n'avais aucun algorithme ou aucune pathologie en tête en particulier. Cependant, on touche à des choses qui sont de l'ordre de la discrimination, peut être indirectes, évoquées par Sarah Benichou. L'algorithme cherche à détecter des sous-jacents qui sont de nature à créer une discrimination entre deux populations. La performance de l'algorithme dépend de sa capacité à reproduire ces différences sous-jacentes. Donc, c'est là qu'on ajoute une couche de complexité à notre discussion. Le biais qui apparaît dans ces réponses peut être lié à un phénomène sous-jacent qui n'est pas présent dans les données qu'il utilise, mais qui est présent dans ce qu'il cherche à détecter. Prenons un exemple : si effectivement la pathologie est liée à la présence de l'expression de tel gène dans le génome, même si l'algorithme n'a pas accès au génome, peut être que l'expression de ce gène dans d'autres critères pris en compte par l'algorithme pourrait conduire l'algorithme à reproduire cette réalité statistique ? Je pense que c'est quelque chose qui est hors de portée du développeur. En l'occurrence, il est difficile de gérer la révélation d'une réalité statistique qui n'est pas présente dans la base de données d'apprentissage, parce que ce sont des corrélations qui sont extérieures à cette donnée d'apprentissage.

Sarah Benichou : Derrière la problématique des outils, il faut aussi évoquer les cas d'usage et leurs applications. De nombreux experts et chercheurs connaissent la réalité des problématiques d'inégalité. S'il y a bien la disposition relative à la discrimination indirecte en droit, c'est parce que des discriminations systémiques et des inégalités existent dans nos sociétés. Ainsi, 80 % des emplois en temps partiels sont occupés par des femmes par exemple. Or le temps de travail n’est évidemment pas un critère de discrimination. Je pourrais multiplier à l'infini les caractéristiques qui font qu'on a des groupes sociaux qui se différencient. On va s'appuyer sur d'autres critères qui sont légaux mais qui en fait, viennent traduire des conduites de groupe. Il faut un regard pluridisciplinaire pour avoir un regard critique sur sa base de données afin de déterminer les points de vigilance. Par exemple, en matière médicale, il y a des conduites en fait très différenciées, des groupes qui ont été parfois soumis à des discriminations et donc moins bien accompagnés. Pendant longtemps, les médicaments n'ont pas été testés sur les femmes comme sur les hommes alors qu'il y a des variables avec le cycle hormonal. Il faut donc réfléchir aux risques que peut poser l'algorithme en s’interrogeant sur la question des usages et dans quel domaine il intervient.

Célia Zolynski : À titre de conclusion, il y a une dernière question qui nous est posée dans la discussion par un de nos collègues géographes s'agissant de l'ampleur géographique du partage de ces approches dans la communauté scientifique au-delà d'Europe et des États-Unis. Quid de la Chine par exemple? Avez-vous aussi un regard tourné vers d'autres zones géographiques ?

Sarah Benichou : On peut noter que du point de vue ISO pour l'intelligence artificielle, tous les continents sont représentés.

Célia Zolynski [01:34:12] Cela sera peut être l'objet d'autres discussions à venir. Il me reste à vous remercier, notamment Winston Maxwell et Mélanie Gornet qui ont co-organisé ce webinaire. Pour vos échanges et vos éclairages, je remercie les panélistes et je remercie le public d'être resté nombreux.

Visionnez l'intégralité du webinaire sur "La reconnaissance faciale : vers une convergence transatlantique des normes techniques en matière d'équité ?"

| LNE | Référentiel de certification de processus pour l'IA - Conception, développement, évaluation et maintien en conditions opérationnelles | Publiée | https://www.lne.fr/fr/service/certification/certification-processus-ia |

|

ISO/IEC JTC 1/SC 37 |

ISO/IEC TR 22116 Information technology – A study of the differential impact of demographic factors in biometric recognition system performance | Publiée | https://www.iso.org/standard/72604.html |

|

ISO/IEC JTC 1/SC 37 |

ISO/IEC WD 19795-10, Information technology — Biometric performance testing and reporting — Part 10: Quantifying biometric system performance variation across demographic groups |

En développement | https://www.iso.org/standard/81223.html |

|

ISO/IEC JTC 1/SC 42 |

ISO/IEC TR 24027:2021, Information technology — Artificial intelligence (AI) — Bias in AI systems and AI aided decision making | Publiée | https://www.iso.org/standard/77607.html |

| NIST | Face Recognition Vendor Test (FRVT) Part 8: Summarizing Demographic Differentials | Publiée | https://pages.nist.gov/frvt/reports/demographics/nistir_8429.pdf |

|

CEN-CLC JTC 21/WG 4 |

AI Trustworthiness characterization | En développement | |

| IEEE | IEEE P7003™ standard for algorithmic bias considerations | En développement | https://standards.ieee.org/ieee/7003/6980/ |